Redazione RHC : 23 julio 2025 08:28

La inteligencia artificial (IA) es una disciplina que busca desarrollar sistemas capaces de emular algunas de las capacidades cognitivas humanas.

A lo largo de los años, la IA ha atravesado diferentes fases, con periodos de intensa actividad seguidos de periodos de desaceleración. En este artículo, exploraremos la historia de la inteligencia artificial y sus momentos cruciales.

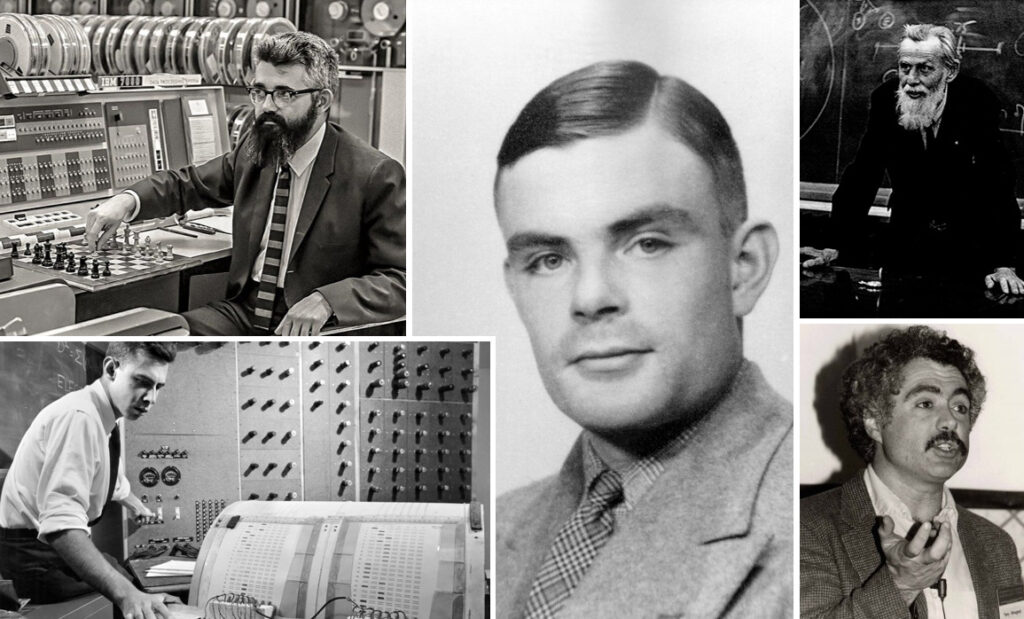

En las décadas de 1950 y 1960, numerosos científicos e investigadores contribuyeron a la fundación de la IA, beneficiándose de las inversiones gubernamentales que apoyaban la investigación en este campo. Algunos de los hitos clave que marcaron el nacimiento de la inteligencia artificial:

En la década de 1970, la IA se enfrentó a varios desafíos que ralentizaron su progreso. Un evento significativo fue el caso XOR, presentado por Marvin Minsky y Seymour Papert en su libro de 1969 «Perceptrones», que destacó las limitaciones de los modelos perceptrónicos para resolver problemas complejos, como replicar el comportamiento de la función XOR. En particular, se demostró que una sola capa de unidades conectadas solo puede clasificar entradas que puedan separarse por una línea recta o un hiperplano.

Otro acontecimiento significativo que contribuyó a la ralentización de la IA fue la publicación del Informe ALPAC en 1966, elaborado por el Comité Asesor de Procesamiento Automático del Lenguaje. El comité destacó las limitaciones de la IA en el campo de la traducción automática del ruso al inglés. La traducción automática era un objetivo estratégico para Estados Unidos, pero el informe enfatizó que, a pesar de los esfuerzos dedicados, los sistemas de traducción automática habían logrado resultados decepcionantes.

Estos análisis, combinados con un bajo retorno de la inversión, llevaron a cuestionar la eficacia de las redes neuronales artificiales y a un período de escepticismo y desilusión con la IA. Sin embargo, es importante destacar que el primer «invierno» de la IA también dejó importantes lecciones aprendidas. Las limitaciones de los perceptrones pusieron de relieve la necesidad de desarrollar modelos de IA más complejos y adaptables. Además, este período de reflexión contribuyó a una mayor conciencia de los retos y problemas que acompañan al desarrollo de la IA.

La década de 1980 presenció un resurgimiento significativo en la investigación y el desarrollo de la IA, impulsado principalmente por la IA simbólica. Esta rama del aprendizaje automático se centra en la representación del conocimiento y el uso de reglas e inferencias para abordar problemas complejos. Los sistemas expertos y los sistemas basados en el conocimiento se desarrollaron como herramientas para resolver problemas complejos aprovechando bases de conocimiento representadas principalmente como reglas condicionales. Un ejemplo notable es SHRDLU, desarrollado por Terry Winograd. SHRDLU era un programa de IA que interactuaba con el mundo a través del lenguaje natural, demostrando cierta comprensión del contexto y la semántica, a pesar de basarse en enfoques basados en reglas.

Además de los sistemas expertos, otro hito de este período fue el Stanford Cart, un carro desarrollado en Stanford capaz de realizar tareas físicas complejas, como transportar objetos a través de un entorno lleno de obstáculos. Esto demostró la capacidad de los robots para manipular objetos físicos de forma autónoma, abriendo nuevas perspectivas para la aplicación práctica de la IA. ¡Puedes ver el carrito Stanford recorriendo una habitación mientras evitas obstáculos en el video a continuación!

La década de 1980 también se caracterizó por el estudio teórico de algoritmos fundamentales para la IA, como el algoritmo de retropropagación, popularizado en 1986 por uno de los padres de la IA moderna, Geoffrey Hinton. Este algoritmo, que aprovecha la retroalimentación de errores en los procesos de aprendizaje, mejoró la capacidad de las redes neuronales para adaptarse a los datos, abriendo nuevas posibilidades para la IA. ¡Aprenda más con esta conferencia de Hinton!

A pesar de los notables avances, la IA enfrentó algunos desafíos y reveses a finales de la década de 1980 y principios de la de 1990. En particular, los sistemas expertos presentan varias limitaciones, como su dependencia de la información proporcionada inicialmente y su limitada adaptabilidad entre dominios. Además, mantener y actualizar la base de conocimientos requiere un esfuerzo y unos costes considerables. Esto condujo a recortes en la inversión en investigación en IA, que en aquel momento aún dependía en gran medida de la financiación pública.

En las últimas décadas, la inteligencia artificial ha experimentado un notable renacimiento gracias a la explosión del aprendizaje automático (ML) y el aprendizaje profundo (DL). Algunos de los desarrollos clave de este período:

Introducción de las Redes Neuronales Multicapa: En 2015, la IA marcó un punto de inflexión con la introducción de las Redes Neuronales Profundas (RPP). Modelos como AlexNet sentaron las bases para redes neuronales capaces de aprender representaciones complejas a partir de datos. El RP ha revolucionado muchos campos, como el procesamiento del lenguaje natural (LEN) y la visión artificial.

Hardware de GPU: El aumento de la potencia de procesamiento ha sido un factor crucial en el auge de la IA. Los avances en la tecnología de hardware, en particular la introducción de procesadores gráficos (GPU) de alto rendimiento, han proporcionado a las máquinas los recursos necesarios para entrenar modelos complejos.

Concurso anual de clasificación ILSVRC: Lanzado en 2010, ha desempeñado un papel clave en el avance del procesamiento de imágenes. El concurso se basa en el conjunto de datos ImageNet, con más de 15 millones de imágenes pertenecientes a más de 20.000 clases. Gracias a los métodos de aprendizaje automático (DL), los errores de clasificación se han reducido significativamente, abriendo nuevas perspectivas en el campo de la visión artificial.

Comunidad de IA: La evolución de la IA ha sido impulsada por el intercambio de conocimientos. La apertura del código, los conjuntos de datos y las publicaciones científicas ha sido crucial. Los frameworks de código abierto como TensorFlow y PyTorch, con el apoyo de importantes empresas de TI (Google y Facebook), han impulsado el desarrollo. Esto ha permitido a investigadores y desarrolladores acceder a herramientas y recursos para la experimentación. Las competiciones de aprendizaje automático se han convertido en plataformas de referencia para compartir modelos, adquirir conjuntos de datos y colaborar entre investigadores.

Inversión privada: Los gigantes tecnológicos han reconocido el potencial de la IA para transformar sus productos y servicios y abrir nuevas oportunidades de negocio. Como resultado, han destinado fondos considerables a la investigación y el desarrollo de IA.

La historia de la IA se caracteriza por períodos de entusiasmo y descubrimiento, seguidos de momentos de desafío y reveses. Sin embargo, en las últimas décadas, la IA ha logrado avances significativos gracias a la evolución del aprendizaje automático y el aprendizaje profundo. La IA simbólica fue pionera en la representación del conocimiento y el uso de reglas e inferencias, mientras que el aprendizaje automático y el aprendizaje profundo han revolucionado el enfoque del aprendizaje automático, permitiendo que las máquinas aprendan de grandes cantidades de datos. A medida que continuamos explorando las posibilidades de la IA, es crucial considerar también los desafíos éticos y sociales que acompañan su desarrollo y uso. La IA es muy prometedora, pero cuestiones como la privacidad, la seguridad, la responsabilidad y el impacto social deben abordarse cuidadosamente para garantizar un uso responsable y beneficioso. El grupo de IA de RHC tiene como objetivo escribir contenido informativo, con exploraciones en profundidad de los temas tratados en este artículo y mucho más. Puede encontrar más detalles sobre los próximos artículos aquí. ¡Esté atento!

Redazione

Redazione

Un hallazgo excepcional de los primeros tiempos de Unix podría llevar a los investigadores a los mismísimos orígenes del sistema operativo. En la Universidad de Utah se descubrió una cinta magnét...

Imagina una ciudad futurista dividida en dos: por un lado, relucientes torres de innovación; por el otro, el caos y las sombras de la pérdida de control. Esta no es una visión distópica, sino el p...

Había una vez un pueblo con un Bosque Mágico. Sus habitantes se sentían orgullosos de tenerlo, incluso un poco orgullosos. Por eso, todos sacrificaban gustosamente algunas pequeñas comodidades par...

Según informes, los servicios de inteligencia surcoreanos , incluido el Servicio Nacional de Inteligencia, creen que existe una alta probabilidad de que el presidente estadounidense Donald Trump cele...

En 2025, los usuarios siguen dependiendo en gran medida de contraseñas básicas para proteger sus cuentas. Un estudio de Comparitech, basado en un análisis de más de 2 mil millones de contraseñas ...