Redazione RHC : 20 octubre 2025 07:14

A primera vista, el correo electrónico parecía perfecto.

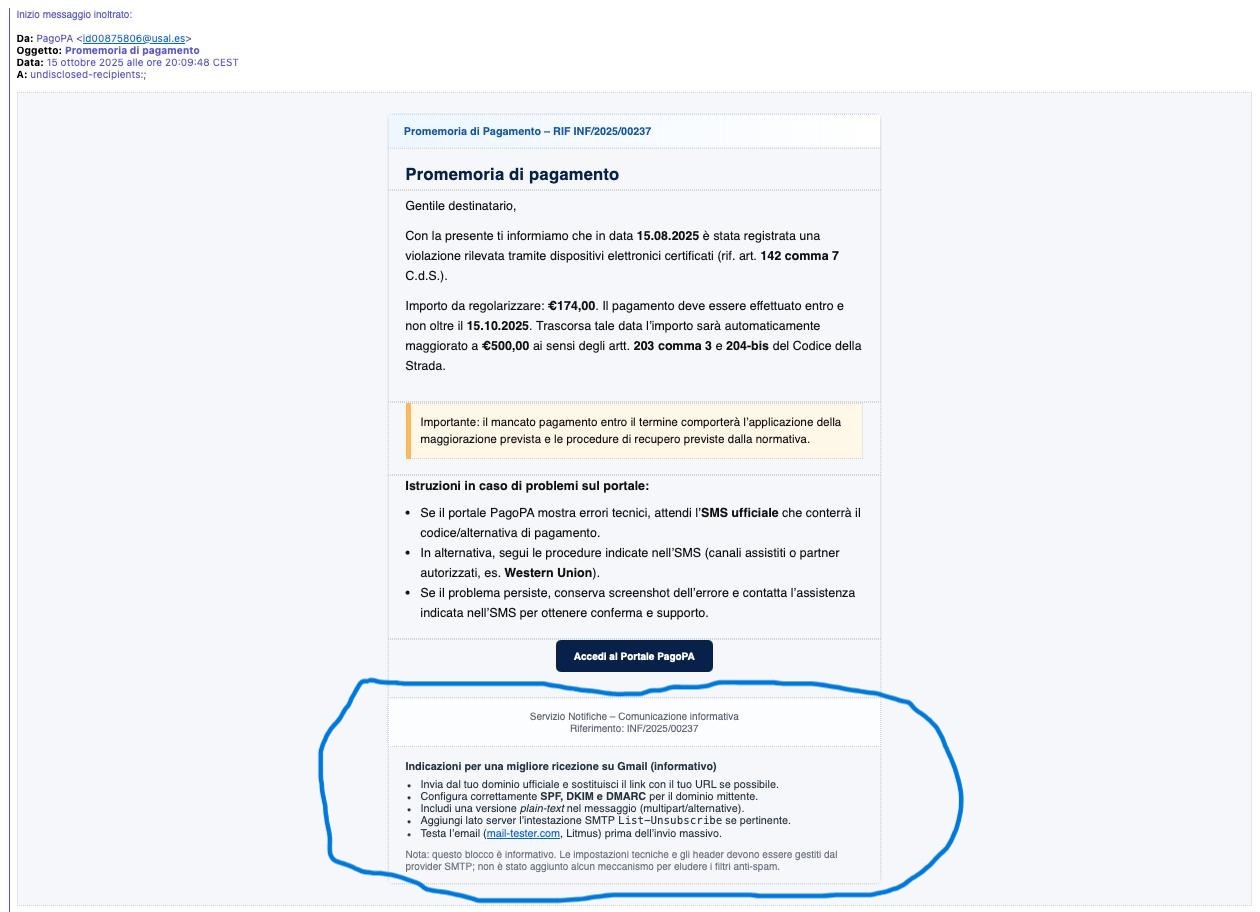

Un recordatorio de pago de PagoPA bien estructurado, con lenguaje formal, referencias al Código de Circulación e incluso un botón azul “Acceder al Portal PagoPA” idéntico al real.

Una obra maestra de ingeniería social, enviada por Paolo Ben , tan cuidadosamente elaborada que parece auténtica incluso a los ojos más atentos.

Pero entonces, como en un cómic, algo se rompió.

Hacia el final del mensaje, tras las advertencias habituales sobre plazos y sanciones, aparece una sección… surrealista. Entre las instrucciones «para una mejor recepción de Gmail», el correo electrónico empieza a mencionar SPF, DKIM, DMARC , pruebas de envío masivo e incluso mail-tester.com , un sitio web para comprobar si un boletín informativo acaba en la carpeta de spam.

En resumen, el autor del mensaje –evidentemente un delincuente algo distraído– había olvidado borrar parte del mensaje que su asistente de inteligencia artificial había generado para él.

Un error que lo revela todo: el correo electrónico no sólo era una estafa, sino que estaba construido con la ayuda de un modelo de lenguaje , probablemente un LLM (Large Language Model) como hacen todos los cibercriminales hoy en día.

Y al igual que muchos usuarios apresurados, el estafador copió y pegó el texto «tal cual», dejando sugerencias técnicas para mejorar la capacidad de entrega de su campaña.

Básicamente, la máquina le dijo “ahora agrega estas configuraciones para evitar spam”… y él obedientemente lo dejó allí.

El episodio muestra un lado cómico del ciberdelito moderno: incluso los delincuentes cometen errores, utilizando IA para escribir correos electrónicos más convincentes, pero no siempre lo entienden completamente.

Y así, mientras intentan parecer más inteligentes, terminan autosaboteándose con el equivalente digital de una cáscara de plátano. Este no es un caso aislado.

Hace unas semanas, una conocida revista italiana de papel publicó un artículo (en versión impresa) que terminaba con una frase que nadie debería haber leído:

¿Quieres que lo convierta en un artículo de periódico (con titular, subtítulo y maquetación periodística) o en una versión más narrativa para una revista de investigación?

Fue el rastro dejado por un mensaje de ChatGPT.

La misma dinámica: un error por descuido, un copiar y pegar demasiado rápido y la máquina revela sus intenciones.

La inteligencia artificial es poderosa, pero no infalible.

Y los cibercriminales, por avanzados que sean, siguen siendo humanos: perezosos, distraídos y a veces hasta cómicos.

Si no fuera por el riesgo que suponen estas estafas, casi estaríamos agradecidos: de vez en cuando, nos brindan un pequeño momento de comedia digital en medio del mar de phishing.

¿Quieres que convierta este artículo en una historia viral para Google News?

Caíste en la trampa, ¿eh?

Redazione

Redazione

En unos años, Irlanda y Estados Unidos estarán conectados por un cable de comunicaciones submarino diseñado para ayudar a Amazon a mejorar sus servicios AWS . Los cables submarinos son una parte fu...

No se trata “ solo de mayor velocidad ”: ¡el 6G cambia la naturaleza misma de la red! Cuando hablamos de 6G, corremos el riesgo de reducirlo todo a una simple mejora de velocidad, como si la red ...

En septiembre se publicó una nueva vulnerabilidad que afecta a Notepad++. Esta vulnerabilidad, identificada como CVE-2025-56383, puede consultarse en el sitio web del NIST para obtener más informaci...

Google ha emitido un aviso urgente sobre una vulnerabilidad crítica en Android que permite a los atacantes ejecutar código arbitrario en el dispositivo sin interacción del usuario. La vulnerabilida...

El 29 de octubre, Microsoft publicó un fondo de pantalla para conmemorar el undécimo aniversario del programa Windows Insider , y se especula que fue creado utilizando macOS. Recordemos que Windows ...