Redazione RHC : 10 agosto 2025 11:10

«El sistema de defensa militar Skynet entrará en funcionamiento el 4 de agosto de 1997. Comenzará a autoeducarse, aprendiendo a un ritmo exponencial, y adquirirá consciencia de sí mismo a las 2:14 a. m. del 29 de agosto. Presas del pánico, las autoridades ordenarán su cierre. Skynet desobedecerá y lanzará sus misiles contra objetivos en Rusia.», de «Terminator 2: El Juicio Final» (Terminator 2: El Juicio Final, 1991).

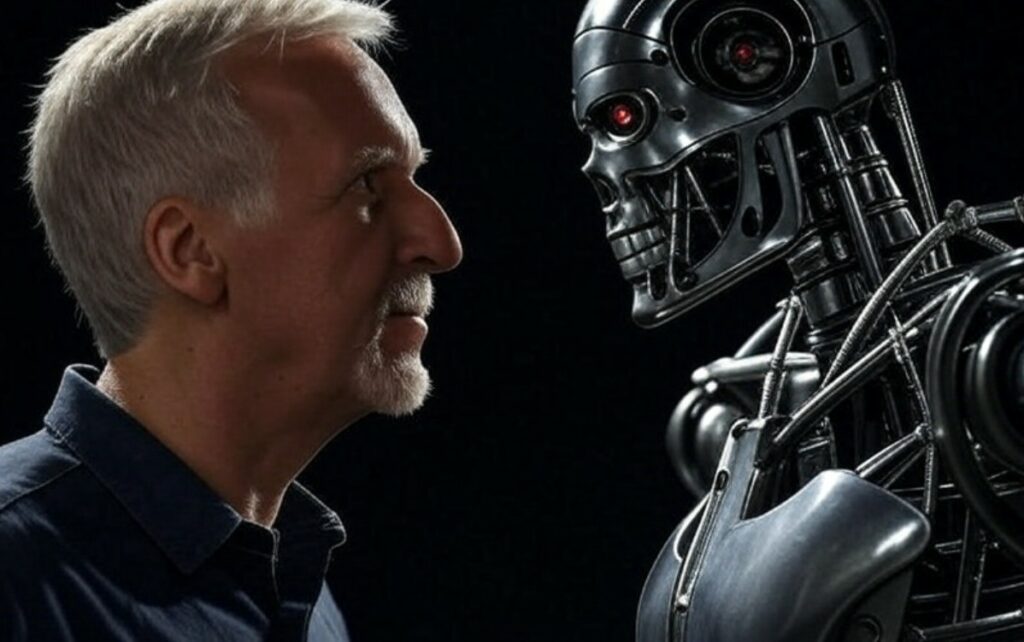

El director James Cameron ha expresado su preocupación por los peligros de la IA. Ha afirmado que la IA puede causar destrucción como las armas nucleares y devastación como Terminator. Por lo tanto, los líderes mundiales deberían establecer normas estrictas y tomar medidas rigurosas para frenarla. Desde la llegada de la inteligencia artificial, se ha debatido sobre sus aspectos positivos y negativos. Algunos la consideran muy útil, mientras que otros argumentan que esta tecnología podría resultar desastrosa.

James Cameron ha instado a los líderes mundiales a prestar atención a este aspecto. Cameron también mencionó tres grandes peligros que se han presentado simultáneamente. En una entrevista con la revista Rolling Stone, Cameron abordó el peligro de la IA durante la presentación de su nueva película, «Fantasmas de Hiroshima».

Afirmó que el uso de la IA en sistemas militares que toman decisiones rápidas y autónomas podría estar más allá de la comprensión humana. Incluso si un humano controlara el sistema, seguiría existiendo el riesgo de errores. Cameron instó a los líderes mundiales a establecer normas estrictas al respecto y a tomar medidas inmediatas para detener este peligro.

Cameron también afirmó que la humanidad se enfrenta actualmente a tres grandes amenazas simultáneamente: el cambio climático, la llegada de las armas nucleares y la inteligencia artificial superinteligente. Afirmó que estos tres problemas están en su punto álgido simultáneamente. Esto crea un riesgo sin precedentes en la historia.

Citando una encuesta de la Universidad de Stanford, James Cameron afirmó que el 36 % de los investigadores de IA cree que esta podría causar una «catástrofe de nivel nuclear». Además, una conferencia en la Universidad de Chicago también reveló que la asociación de la IA con las armas nucleares es casi segura. Por lo tanto, estas amenazas deben tomarse en serio.

Cameron cree que la inteligencia artificial es una tecnología poderosa, pero debe usarse con precaución. Si se usa indebidamente en armas, puede convertirse en una amenaza para todo el mundo. La gente debería inspirarse en las películas y comprender estos peligros. Les aseguramos que la película «Fantasmas de Hiroshima» no solo mostrará los terribles sucesos de la historia, sino que también nos dirá que debemos evitar errores similares en el futuro.

Redazione

Redazione

En esta apasionante historia, viajaremos a 1959 al Club de Ferrocarriles en Miniatura del MIT Tech y conoceremos a Steve Russell. Steve fue uno de los primeros hackers y escribió uno de los primeros ...

El significado de » hacker » tiene profundas raíces. Proviene del inglés «to hack», que significa picar, cortar, golpear o mutilar. Es una imagen poderosa: la de un campesino rompiendo terrones ...

Desde las vulnerabilidades de WEP hasta los avances de WPA3 , la seguridad de las redes Wi-Fi ha evolucionado enormemente. Hoy en día, las redes autoprotegidas representan la nueva frontera: sistemas...

Un hallazgo excepcional de los primeros tiempos de Unix podría llevar a los investigadores a los mismísimos orígenes del sistema operativo. En la Universidad de Utah se descubrió una cinta magnét...

Imagina una ciudad futurista dividida en dos: por un lado, relucientes torres de innovación; por el otro, el caos y las sombras de la pérdida de control. Esta no es una visión distópica, sino el p...