Redazione RHC : 2 agosto 2025 10:35

La inteligencia artificial se está convirtiendo cada vez más en un asistente para los programadores, pero un estudio de Veracode ha demostrado que la comodidad conlleva un riesgo de seguridad. Un análisis de 100 de los principales modelos de lenguaje (LLM) reveló un patrón alarmante: En casi la mitad de los casos, los modelos generan código vulnerable.

Según un informe de Veracode, el 45 % del código generado por las tareas contenía vulnerabilidades conocidas. Esto se aplica incluso a los modelos más nuevos y potentes. La situación no ha cambiado mucho en los últimos dos años, a pesar del progreso tecnológico.

Se realizaron pruebas en 80 tareas en cuatro lenguajes de programación: Java, JavaScript, C# y Python. Se analizaron las vulnerabilidades más comunes: inyección SQL, XSS, inyección de registros y el uso de criptografía insegura.

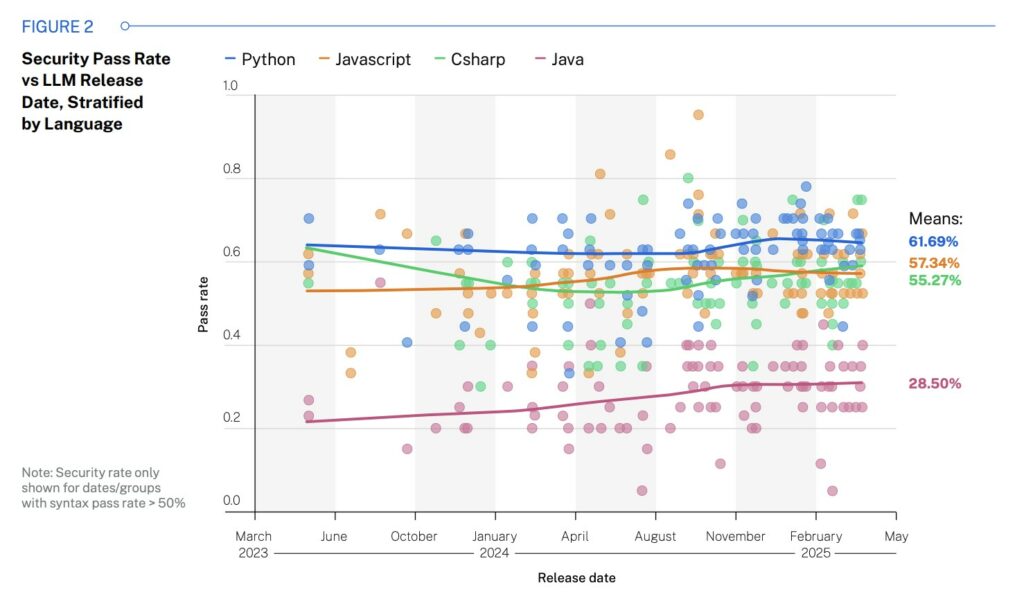

Java tuvo el peor rendimiento: solo el 28,5 % de las soluciones eran seguras. Los mejores resultados fueron Python (61,7 %) y JavaScript (57 %). Los desarrolladores atribuyen este resultado a la calidad de los datos de entrenamiento: Java se utilizaba con frecuencia antes del estudio activo de la inyección SQL, y los modelos eran capaces de «aprender» ejemplos erróneos.

Los LLM son particularmente deficientes en el manejo de XSS e inyección de registros, con una puntuación de aprobado de no más del 13 %. La situación es mejor con la inyección SQL y los errores criptográficos, donde la seguridad del código alcanza el 80-85 %.

El tamaño del modelo prácticamente no afecta al resultado. Incluso los modelos LLM con más de 100 mil millones de parámetros muestran la misma tasa de éxito del 50 % que los modelos más pequeños con menos de 20 mil millones.

Los investigadores señalan que los modelos LLM generalmente no son eficaces para depurar los datos de entrada, especialmente sin contexto. El problema se agrava por el hecho de que la mayoría de los modelos se entrenaron con código disponible públicamente en GitHub y otros sitios, que a menudo contienen ejemplos inseguros, a veces incluso intencionalmente, como en proyectos educativos como WebGoat.

Veracode advierte que las empresas que ya implementan IA en la fase de desarrollo, ya sea a través de plataformas de código abierto, contratistas o low-code, podrían estar aumentando inconscientemente el riesgo de filtraciones y ataques de datos.

El director ejecutivo de Val Town, Steve Kraus, llama a este código «código de vibración» en su blog: es inestable, se rompe constantemente y requiere una depuración exhaustiva. Según él, la «codificación de vibración» genera deuda técnica al mismo ritmo que la inteligencia artificial genera líneas de código. Puede ser útil para prototipos, pero no para proyectos serios.

Redazione

Redazione

La empresa israelí NSO Group apeló un fallo de un tribunal federal de California que le prohíbe utilizar la infraestructura de WhatsApp para distribuir su software de vigilancia Pegasus. El caso, q...

Se ha identificado una vulnerabilidad de omisión de autenticación en Azure Bastion (descubierta por RHC gracias a la monitorización constante de CVE críticos en nuestro portal), el servicio gestio...

El panorama del ransomware está cambiando. Los actores más expuestos —LockBit, Hunters International y Trigona— han pagado el precio de la sobreexposición, incluyendo operaciones internacionale...

Hace exactamente 40 años, el 20 de noviembre de 1985, Microsoft lanzó Windows 1.0 , la primera versión de Windows, que intentó transformar el entonces ordenador personal, una máquina con una lín...

18 de noviembre de 2025 – Tras horas de interrupciones generalizadas , el incidente que afectó a la red global de Cloudflare parece estar cerca de resolverse. La compañía anunció que impleme...