L’intelligenza artificiale è ovunque. La usiamo per scrivere email, generare immagini, cercare informazioni, analizzare dati. L’Intelligenza Artificiale non serve solo ad analizzare dati, è diventata silenziosamente una componente strutturale del software moderno.

Ma mentre celebriamo la “magia” dell’AI lato applicativo, c’è un conto fisico, materiale e molto concreto che sta arrivando sulla scrivania di tutti, anche di chi l’AI non la usa, non la vuole e non la ha mai richiesta.

Non è una scelta individuale: è un costo sistemico.

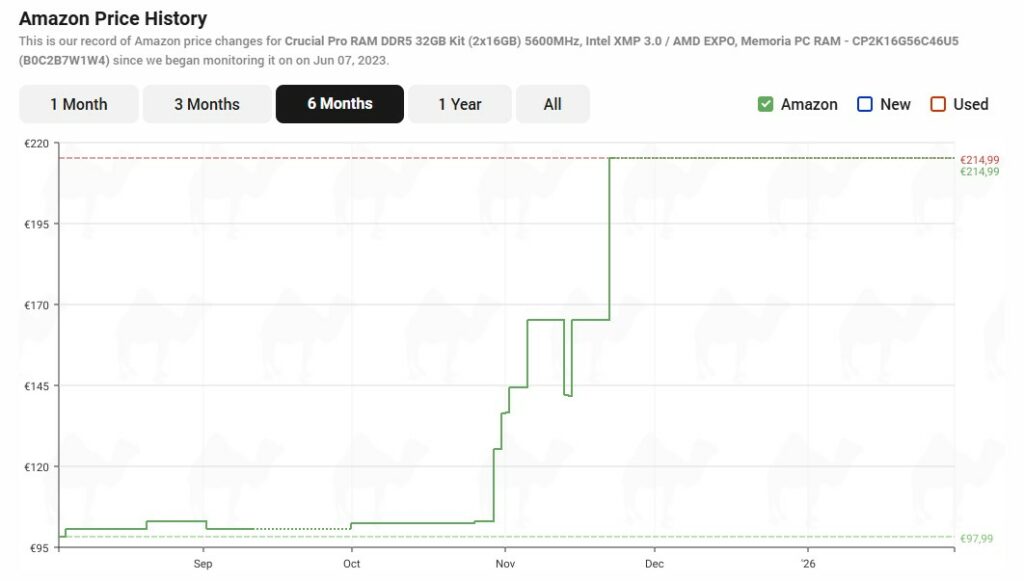

Se negli ultimi mesi hai provato a comprare RAM, SSD o anche solo a pianificare un upgrade o l’acquisto di nuovo hardware, probabilmente te ne sei accorto: i prezzi stanno salendo.

Verificando i prezzi su camelcamelcamel, portale che monitora l’andamento dei prezzi su Amazon, si vede chiaramente come nel giro di pochi mesi molti componenti abbiano raddoppiato il costo.

E no, questa volta l’inflazione è solo una parte marginale della storia.

C’è un dettaglio che spesso sfugge: l’intelligenza artificiale non viene pagata solo attraverso abbonamenti o licenze. Anche quando il costo del servizio è esplicito, non è l’unico costo in gioco. E soprattutto, non è l’unico costo che il sistema genera.

La prima forma di pagamento è quella più nota: denaro e dati. Chi utilizza servizi AI contribuisce con abbonamenti, ma anche con testi, immagini, comportamenti, log di utilizzo e feedback impliciti. È questo insieme che alimenta l’addestramento e il miglioramento continuo dei modelli.

La seconda forma di pagamento è meno visibile ed è indipendente dall’utilizzo diretto: l’hardware.

Più RAM nei pc e server, più storage, upgrade più frequenti, maggiore consumo energetico. Questo costo non è opzionale e non riguarda solo chi usa attivamente l’AI, perché l’intero mercato dell’hardware viene riallineato per sostenere infrastrutture AI-centriche.

Anche chi utilizza il computer solo per lavoro, studio o attività di base si trova a operare in un contesto in cui componenti e dispositivi costano di più, semplicemente perché le priorità produttive e commerciali sono cambiate.

Se si considera anche l’energia necessaria a far funzionare data center, reti e sistemi di raffreddamento, il conto diventa collettivo e strutturale, non legato a una scelta individuale. Il paradosso è evidente: anche i servizi presentati come “gratuiti”, “inclusi” o già “pagati” tramite abbonamento continuano ad avere un costo materiale crescente, che si riflette sull’utente finale e sull’ambiente, a prescindere dal livello di utilizzo reale dell’AI.

Il cuore del problema è una gerarchia industriale brutale ma razionale.

I grandi produttori di memoria, come Samsung, SK Hynix e Micron, stanno riconvertendo gran parte delle linee produttive verso le HBM (High Bandwidth Memory).

Le HBM sono memorie ultra-veloci, costose, impilate, progettate quasi esclusivamente per i server AI: GPU, acceleratori e infrastrutture che tengono in piedi modelli come ChatGPT, Gemini, Claude e simili.

Il risultato è una catena di conseguenze molto concreta:

A rendere il quadro ancora più concreto sono anche le notizie recenti. Secondo Reuters e Bloomberg, Samsung e SK Hynix hanno siglato accordi preliminari per fornire memoria al data center Stargate di OpenAI. In questo caso non si parla di chip DRAM già pronti o di stack HBM completi, ma di wafer DRAM non tagliati, un segnale dei volumi richiesti.

Le stime indicano una domanda fino a 900.000 wafer al mese, pari a circa il 40% della produzione globale di DRAM. L’accordo includerebbe diverse tipologie di memoria, dalla DDR5 standard alle HBM per carichi AI, mettendo inevitabilmente sotto pressione anche il mercato consumer.

Per anni abbiamo dato per scontato che lo storage sarebbe diventato sempre più economico.

Costo per gigabyte in caduta libera, SSD sempre più capienti, HDD enormi a prezzi irrisori.

I modelli di intelligenza artificiale hanno una fame insaziabile di dati e hanno bisogno di leggerli e scriverli a velocità estreme. I data center stanno assorbendo enormi quantità sia di NAND enterprise, per SSD ad alte prestazioni, che di HDD ad alta capacità per archiviare dataset di addestramento giganteschi

Questa corsa crea una carenza a catena che si riflette anche sul mercato consumer.

Se il tuo prossimo SSD ti sembra “troppo caro per quello che offre”, non è una sensazione ma un effetto sistemico.

L’intelligenza artificiale può essere paragonata all’automobile come oggetto tecnologico. Il costo del veicolo in sé appare spesso accessibile e circoscritto, talvolta persino marginale rispetto ai benefici che promette. Ma quel prezzo non ha mai rappresentato il costo reale della mobilità.

A renderla possibile è sempre stato un ecosistema molto più ampio fatto di strade, infrastrutture, distribuzione di energia, manutenzione, logistica e risorse condivise, sostenute collettivamente anche da chi non guida o non possiede un’auto.

L’AI segue la stessa logica. Il costo del software, dell’abbonamento o dell’accesso diretto è solo la parte visibile. Al di sotto esiste una rete materiale composta da data center, filiere produttive del silicio, reti energetiche, sistemi di raffreddamento e consumo di risorse che viene costruita e mantenuta su scala sistemica. Non è un’infrastruttura che paga solo chi utilizza attivamente l’AI, ma una struttura che ridefinisce priorità industriali ed economiche per l’intero ecosistema digitale.

Come per l’automobile, l’adozione diffusa dell’intelligenza artificiale genera benefici reali, ma anche costi strutturali che vengono socializzati. Hardware più costoso, maggiore pressione energetica e impatti ambientali non sono effetti temporanei o marginali, ma conseguenze dirette di una tecnologia che si comporta come infrastruttura, non come semplice funzione software.

Riconoscere questo parallelismo non significa rifiutare l’AI, così come nessuno ha rifiutato l’automobile come mezzo. Significa smettere di considerarla immateriale e “gratuita” e iniziare a valutarne l’adozione con maggiore consapevolezza, sapendo che ogni chilometro percorso richiede strade che qualcuno, in qualche modo, sta già pagando.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.