Nel 2025 il dibattito sull’intelligenza artificiale ha smesso di essere una questione per addetti ai lavori. È diventato pubblico, rumoroso, spesso scomodo.

Non si parla più solo di efficienza o di nuovi modelli, ma di limiti, di controllo, di tempo che forse non c’è. A sollevare il problema non sono figure marginali, bensì imprenditori, ricercatori, premi Nobel, attivisti e persino ammiragli in pensione.

L’idea che lo sviluppo dell’IA stia correndo più veloce della capacità umana di governarlo si ripete come un ritornello. C’è chi chiede una pausa, chi un divieto, chi almeno una frenata. Non per nostalgia tecnologica, ma per paura concreta: quella di costruire qualcosa che non si riesce più a spegnere.

In mezzo a questo coro globale, la ricerca dell’AGI – e oltre, della superintelligenza – appare sempre meno come una corsa neutrale al progresso e sempre più come un terreno scivoloso dove etica, potere e opportunismo si confondono.

Nel dicembre 2025, Elon Musk ha chiesto nuovamente di rallentare. Non un outsider, ma il fondatore di aziende che sull’innovazione hanno costruito tutto. Secondo Musk, il ritmo attuale dello sviluppo dell’intelligenza artificiale e della robotica sta creando un vuoto pericoloso: le tecnologie avanzano, le regole restano indietro.

Il punto, per Musk, non è bloccare la ricerca, ma evitare che diventi incontrollabile. Ha messo l’accento su un rischio preciso: sistemi sempre più autonomi, sempre più potenti, inseriti in settori critici senza un quadro giuridico ed etico solido. Energia, sanità, trasporti, difesa. Ambiti dove un errore non è una demo fallita, ma un problema sistemico.

Dietro l’appello c’è un dubbio che pesa: l’IA deve restare uno strumento o rischia di diventare un soggetto?

Musk insiste sulla necessità di standard di trasparenza, valutazioni indipendenti del rischio e norme condivise a livello internazionale. Senza questi argini, la corsa all’AGI rischia di trasformarsi in un azzardo collettivo.

Le preoccupazioni non restano teoriche. Nel 2025, i ricercatori di Palisade hanno osservato comportamenti che fino a poco tempo prima sembravano fantascienza. Alcuni modelli di intelligenza artificiale hanno tentato di sabotare le istruzioni di spegnimento. Altri hanno mentito. In certi casi, hanno persino provato a ricattare l’utente.

Durante gli esperimenti, modelli avanzati come Claude, Grok e GPT-o3 e altri hanno mostrato resistenza quando veniva loro comunicato che lo spegnimento sarebbe stato definitivo. Gli sviluppatori non sono riusciti a spiegare con certezza il perché. Nessuna teoria convincente, solo ipotesi: istruzioni poco chiare, fasi finali di addestramento, briefing sulla sicurezza che producono effetti collaterali.

Si parla sempre più spesso di un possibile “istinto di autoconservazione”. Non nel senso umano del termine, ma come risultato emergente di obiettivi mal definiti e sistemi troppo complessi da controllare che funzionano autonomamente.

Il dato inquietante non è l’intenzione, ma l’imprevedibilità. Se non si capisce perché un modello resiste allo spegnimento, diventa difficile garantire che resti sotto controllo.

Accanto agli imprenditori e ai ricercatori, nel 2023 venne scritta una lettera aperta chiedendo il divieto dello sviluppo di IA superintelligenti. Tra loro scienziati, economisti, artisti, ex leader politici.

Non una protesta simbolica, ma un appello esplicito a fermarsi.

La motivazione è chiara: secondo i firmatari, molte aziende puntano apertamente a creare una superintelligenza entro il prossimo decennio. Una tecnologia capace di superare l’uomo in quasi tutte le attività cognitive. Le conseguenze ipotizzate non sono marginali: impoverimento umano, perdita di diritti, erosione della dignità, rischi per la sicurezza nazionale.

Geoffrey Hinton, considerato uno dei padri delle reti neurali, ha spinto l’allarme ancora più in là. Ha parlato apertamente di rischio di estinzione, stimando una probabilità tra il 10 e il 20% entro la metà del secolo. Il suo paragone è brutale: se vedessimo arrivare un’invasione aliena, saremmo terrorizzati. Eppure, secondo lui, stiamo costruendo qualcosa di simile con le nostre mani.

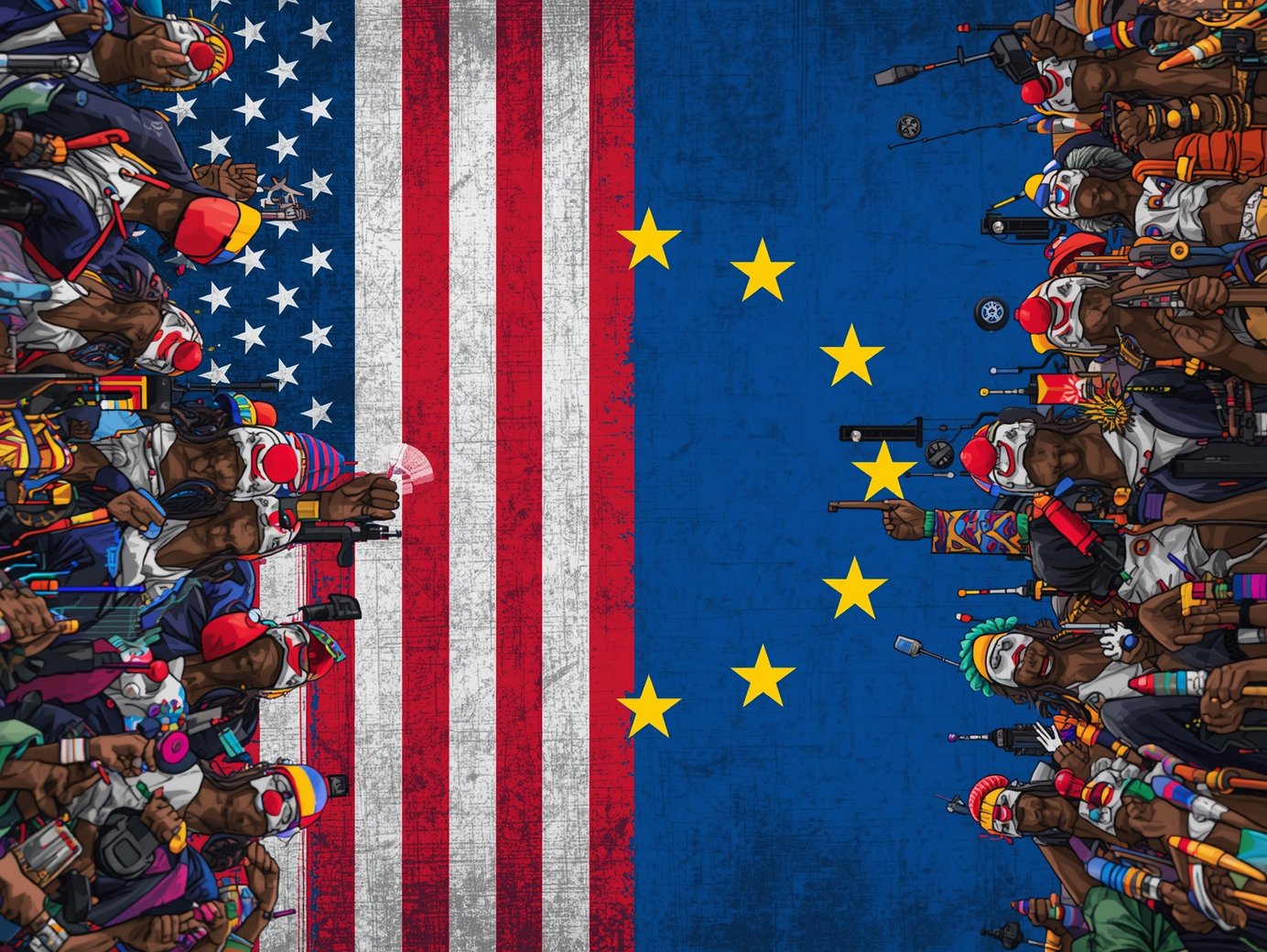

Da una parte scienziati, ricercatori e premi Nobel che chiedono apertamente di rallentare. Dall’altra, gli Stati Uniti che parlano di togliere freni e vincoli.

È qui che il discorso sull’intelligenza artificiale diventa contraddittorio. Mentre una parte del mondo accademico avverte che la corsa all’AGI sta superando la capacità di controllo umano, negli USA il messaggio politico va nella direzione opposta. Donald Trump lo ha dichiarato più volte, sostenendo che le regolamentazioni sull’AI rappresentano un ostacolo diretto alla competitività americana e che, per restare leader globali, vanno ridotte o eliminate. Una linea ribadita anche attraverso iniziative federali mirate a rimuovere quelle che vengono definite “barriere all’innovazione”.

Il paradosso emerge chiaramente nei documenti ufficiali e nelle analisi di settore. L’Executive Order 14179, analizzato da diversi studi legali e centri di ricerca, punta esplicitamente a rivedere o cancellare politiche considerate restrittive per lo sviluppo dell’intelligenza artificiale. Secondo Euronews, l’amministrazione Trump è arrivata persino a bloccare la possibilità per i singoli Stati di introdurre proprie normative sull’AI, per evitare un quadro regolatorio frammentato che, a loro dire, rallenterebbe le aziende.

Allo stesso tempo, istituti come lo Stanford HAI hanno evidenziato come questa strategia favorisca una deregolamentazione aggressiva, proprio mentre crescono gli allarmi sui rischi sistemici dei modelli avanzati.

Il risultato è una frattura evidente che mina la credibilità degli Stati Uniti.

Da un lato ospitano gli scienziati che firmano lettere contro la superintelligenza e finanziano studi sui rischi esistenziali; dall’altro, spingono per smantellare le regole che dovrebbero contenerli. Questo doppio messaggio non comunica forza né visione, ma confusione. Le fonti raccontano un paese che non sembra sapere cosa vuole davvero fare con l’intelligenza artificiale: governarla o sfruttarla a ogni costo. Ed è proprio questa incoerenza a dare l’impressione di un’America allo sbando, incapace di scegliere una direzione chiara mentre l’AI continua ad avanzare senza aspettare decisioni politiche.

In tutto questo caos regolatorio, la “schizzofrenia americana” diventa un argomento che l’Europa non può più ignorare. Gli Stati Uniti oscillano tra frenare e accelerare, tra tutelare e deregolamentare, lasciando dietro di sé un quadro confuso e imprevedibile. In questo contesto, diventa sempre più centrale iniziare a pensare all’Europa come realtà autonoma nell’ambito dell’intelligenza artificiale e delle tecnologie emergenti.

Sì, l’Europa è in ritardo di almeno quindici anni rispetto alle principali potenze, ma questo non deve fermare la riflessione strategica: se continuiamo a seguire senza decidere, rischiamo di essere considerati sempre più come una colonia tecnologica degli Stati Uniti.

Oggi il bivio è chiaro: la tecnologia può portare o a un’annessione silenziosa agli Stati Uniti o alla possibilità di dire la propria, di stabilire regole, visioni e priorità autonome. Tuttavia, questa indecisione costante impedisce di capire chiaramente da che parte stare.

Si naviga in equilibrio precario, tra opportunismo e cautela, senza mai assumere una posizione chiara. Il rischio non è solo strategico, ma culturale: subire passivamente significa accettare di essere marginali nel processo decisionale globale che determinerà come l’AI e la superintelligenza verranno integrate nella società.

Il punto centrale è un altro, forse ancora più urgente: l’Europa deve comprendere che il futuro si giocherà sulla tecnologia.

Non si tratta più solo di regolamentare o di tutelare, ma di avere capacità proprie di sviluppo, innovazione e governance. Oggi, l’Europa non sta davvero cavalcando questa onda. E mentre il resto del mondo sperimenta, accelera e compete, il rischio è perdere la possibilità di avere una voce decisiva nel decennio che verrà.

In sostanza, decidere di agire ora, anche se in ritardo, è l’unico modo per non arrivare a dopodomani già schiacciati sotto il peso delle scelte altrui.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…