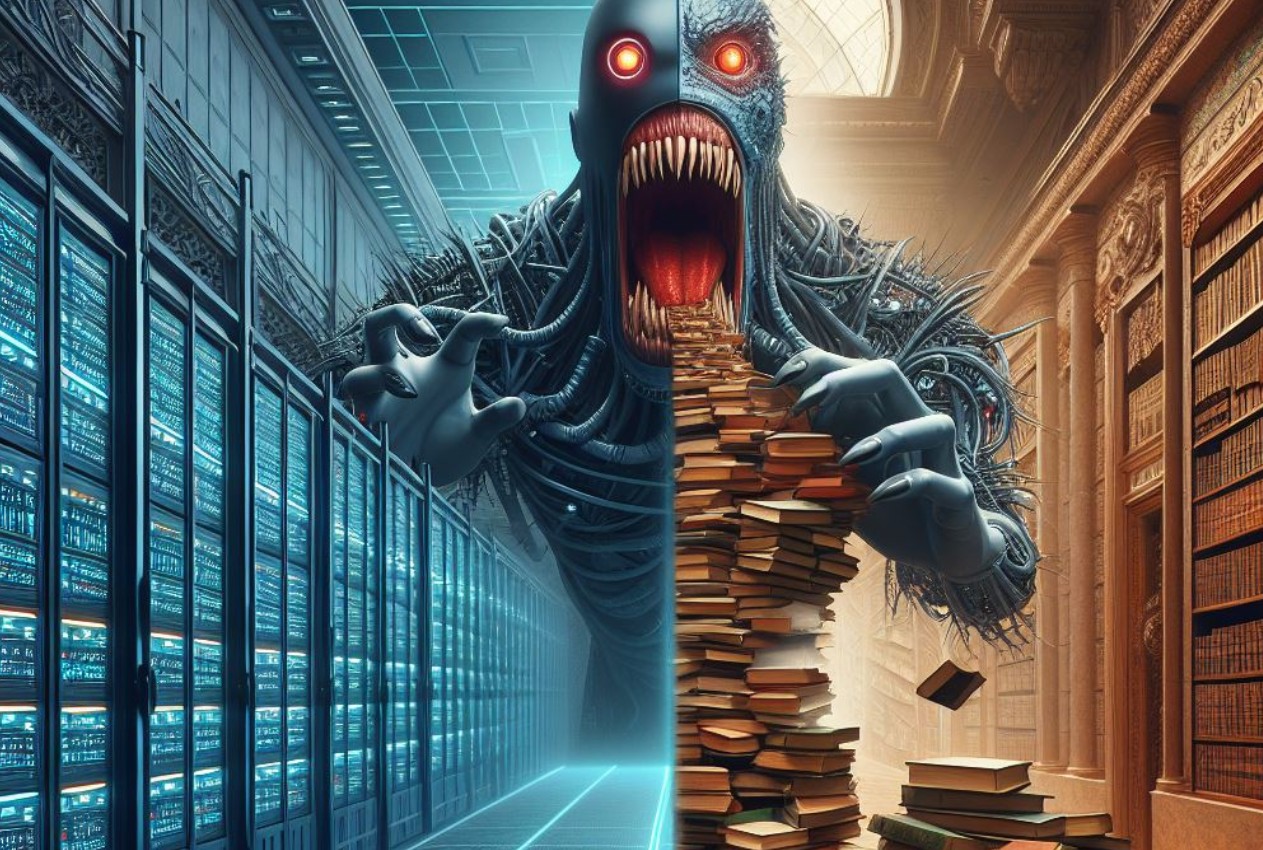

Le aziende che sviluppano l’intelligenza artificiale si trovano ad affrontare un nuovo problema: il volume di Internet potrebbe non essere sufficiente per i loro ambiziosi progetti. Il Wall Street Journal ha descritto le possibili prospettive nel campo dell’intelligenza artificiale.

La crescente potenza dei sistemi sviluppati da OpenAI, Google e altri richiede quantità sempre maggiori di informazioni per la formazione, portando a tensioni nel mercato dei dati pubblici. Tuttavia, alcuni proprietari di dati ne limitano l’accesso alle società di intelligenza artificiale.

Supporta Red Hot Cyber

Gli esperti del settore avvertono che la domanda di dati testuali di alta qualità potrebbe superare l’offerta entro due anni, rallentando potenzialmente il progresso dell’intelligenza artificiale. Pertanto le aziende sono alla ricerca di fonti di informazione non ancora sfruttate e stanno ripensando il modo in cui addestrano i propri sistemi.

OpenAI sta valutando la possibilità di addestrare il suo prossimo modello, GPT-5, sulle trascrizioni video di YouTube. Sono in corso anche esperimenti utilizzando dati sintetici, anche se molti ricercatori ritengono che ciò possa portare a gravi fallimenti nei modelli.

La mancanza di dati è solo una delle sfide che il settore dell’intelligenza artificiale deve affrontare. Inoltre, vi è una carenza di chip necessari per eseguire modelli linguistici di grandi dimensioni come ChatGPT e Gemini, nonché una mancanza di dati ed elettricità per alimentarli.

I modelli linguistici dell’intelligenza artificiale vengono addestrati su testi provenienti da Internet, comprese ricerche scientifiche, articoli di notizie e articoli di Wikipedia. Si ritiene che più dati vengono utilizzati per l’addestramento, più efficace diventa il modello. Tuttavia, gli esperti stimano che anche l’utilizzo di tutti i dati linguistici e delle immagini disponibili di alta qualità potrebbe creare un deficit di 10-20 trilioni di token o più.

Allo stesso tempo, le piattaforme social, i notiziari e altri operatori di mercato stanno limitando l’accesso ai propri dati per la formazione sull’intelligenza artificiale a causa delle preoccupazioni sull’equo compenso. Anche la posizione aperta sull’utilizzo di dati privati per addestrare i modelli non è ampiamente supportata.

Diverse aziende, tra cui OpenAI e Anthropic, stanno esplorando la possibilità di creare dati sintetici di alta qualità per addestrare i propri modelli ad evitare i problemi che sorgono quando si utilizza testo generato artificialmente.

Tuttavia, il settore rimane ottimista riguardo alla ricerca di soluzioni alle attuali sfide legate ai dati. Gli esperti paragonano la situazione attuale al “picco del petrolio”, suggerendo che, come lo sviluppo di tecnologie per superare le crisi petrolifere, potrebbero emergere soluzioni rivoluzionarie anche nel campo dell’intelligenza artificiale.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.