È il nuovo fuzzing del futuro? Con ogni probabilità sarà un approccio combinato multi agente, dove le AI assieme al bug hunter saranno in grado di ridurre drasticamente i tempi di individuazione dei bug 0-day. I primi segnali sono già visibili, seppur ancora in forma limitata, in alcune vulnerabilità recenti, come quella emersa di recente su Apache bRPC.

Il team di ricerca di CyberArk Labs ha progettato Vulnhalla, uno strumento open‑source concepito per filtrare i risultati di CodeQL – il motore di analisi statica di GitHub – e isolare solo gli allarmi con reale potenziale di vulnerabilità.

Ovviamente, ridurre la velocità di rilevazione degli 0day, porterà di conseguenza ad un aumento delle attività criminali. Ma questo è un altro argomento da analizzare con attenzione ma non in questo articolo.

Strumenti come CodeQL generano migliaia di segnalazioni su grandi codebase, molte delle quali risultano falsi positivi. Ciò si traduce in un enorme impegno manuale per sviluppatori e ricercatori, tanto che un singolo team potrebbe impiegare anni per rivedere tutto il materiale prodotto da una singola esecuzione di analisi su progetti complessi.

La difficoltà di questi strumenti nasce da due sfide principali nell’uso dell’IA per l’analisi del codice:

Senza indicazioni precise, un modello di linguaggio può facilmente perdersi tra risultati irrilevanti o fuorvianti.

CodeQL è uno strumento di analisi statica sviluppato da GitHub che permette di eseguire query su codice sorgente per individuare potenziali vulnerabilità o bug. Funziona trasformando il codice in un database relazionale interrogabile, dove ogni funzione, variabile e flusso logico può essere analizzato in modo automatico.

Grazie a questo approccio, gli sviluppatori e i ricercatori possono cercare pattern di sicurezza specifici su grandi codebase senza dover leggere manualmente ogni riga di codice. Pur essendo potente, CodeQL genera spesso un elevato numero di falsi positivi, motivo per cui strumenti come Vulnhalla sono stati sviluppati per filtrare i risultati più rilevanti.

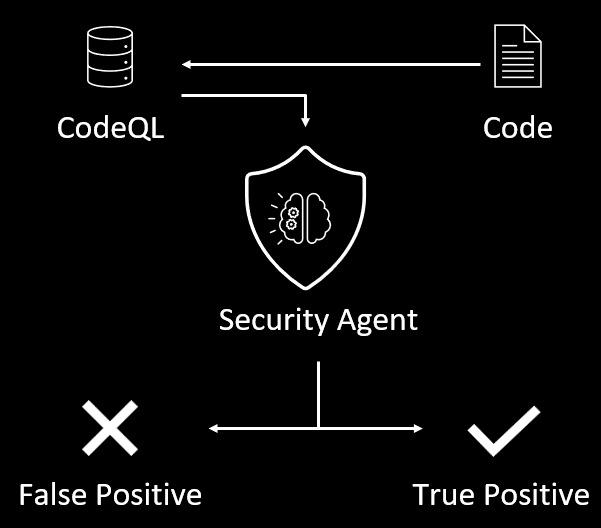

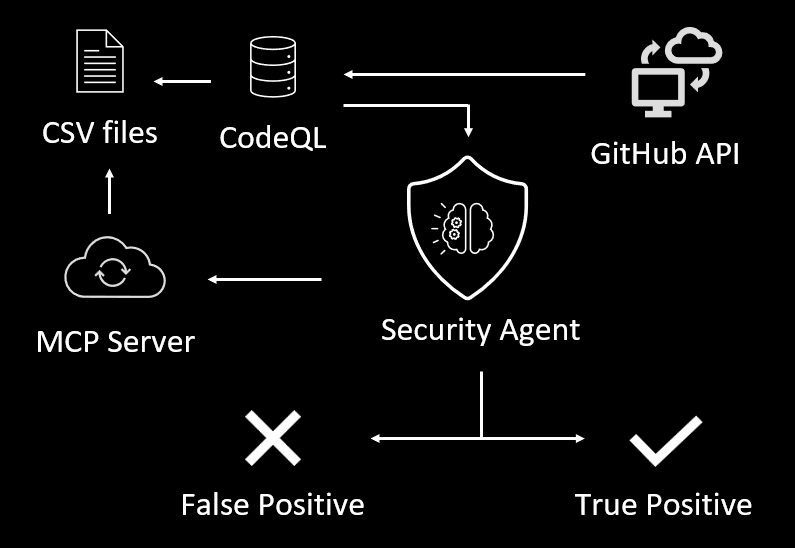

Invece di affidarsi solo all’analisi statica o alla generazione automatica di pattern, Vulnhalla integra il potere di modelli di linguaggio (come GPT‑4o) con CodeQL: ogni segnalazione emessa da CodeQL viene arricchita da contesto estratto automaticamente dal database del codice e poi analizzata dall’IA per determinare se rappresenta una vulnerabilità concreta o un falso positivo.

Questo processo è stato testato su oltre 100 grandi repository open‑source in linguaggio C, con risultati che mostrano una riduzione significativa dei falsi positivi, consentendo di individuare difetti più affidabili in tempi drasticamente inferiori rispetto alla revisione manuale.

In soli due giorni di lavoro, con un budget inferiore a 80 dollari per le chiamate API, Vulnhalla ha permesso ai ricercatori di identificare una serie di vulnerabilità non documentate (CVE) in progetti noti, tra cui:

Per permettere all’IA di giudicare correttamente ogni segnalazione, Vulnhalla attinge al database CodeQL per estrarre il contesto rilevante al momento giusto. Invece di interrogare CodeQL dinamicamente per ogni richiesta – operazione lenta e onerosa – lo strumento genera file CSV pre‑indicizzati con informazioni su funzioni, strutture e variabili, consentendo un recupero dei dati in pochi secondi anziché minuti.

L’esperimento ha mostrato che alcune classi di allarmi possono vedere una riduzione dei falsi positivi fino al 96%, snellendo significativamente il lavoro di triage. Tuttavia, anche una segnalazione “vera” non equivale necessariamente a una falla sfruttabile nella pratica: molte possono trovarsi in codice di test, non essere mai invocate, o non avere impatti di sicurezza reali.

Vulnhalla rappresenta un passo sostanziale verso l’automatizzazione della scoperta di vulnerabilità reali in grandi codebase, integrando analisi statica e capacità di ragionamento dei moderni modelli di linguaggio.

Il progetto è disponibile come open source su GitHub e il team invita la comunità a contribuire per estendere il supporto ad altri linguaggi e tipi di issue.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.