il 5 aprile scorso, Google ha rilasciato i dettagli su uno dei suoi nuovi supercomputer AI. La società afferma che lo sviluppo supera i sistemi Nvidia concorrenti in termini di velocità ed efficienza.

Mentre Nvidia domina il mercato dell’implementazione di modelli di intelligenza artificiale (oltre il 90% del mercato), Google si è concentrata sullo sviluppo di propri chip ad alte prestazioni dal 2016, chiamati Tensor Processing Units (TPU).

Cybersecurity Awareness efficace? Scopri BETTI RHC! Sei un'azienda innovativa, che crede nella diffusione di concetti attraverso metodi "non convenzionali"? Red hot cyber ha sviluppato da diversi anni una Graphic Novel (giunta al sesto episodio), l'unica nel suo genere nel mondo, che consente di formare i dipendenti sulla sicurezza informatica attraverso la lettura di un fumetto. Contattaci tramite WhatsApp al numero 375 593 1011 per saperne di più e richiedere informazioni oppure alla casella di posta graphicnovel@redhotcyber.com

Se ti piacciono le novità e gli articoli riportati su di Red Hot Cyber, iscriviti immediatamente alla newsletter settimanale per non perdere nessun articolo. La newsletter generalmente viene inviata ai nostri lettori ad inizio settimana, indicativamente di lunedì. |

Tuttavia, negli ultimi dieci anni, Google ha fatto molto per lo sviluppo dell’intelligenza artificiale. I dipendenti della società americana hanno sviluppato molte tecnologie chiave che sono attualmente utilizzate ovunque.

Tuttavia, in termini di commercializzazione dei suoi sviluppi, secondo molti, l’azienda è notevolmente indietro rispetto ai suoi concorrenti.

Negli ultimi anni si è creata un’atmosfera sfavorevole all’interno dell’azienda, costringendo sviluppatori e ingegneri a presentare un prodotto che dimostrerebbe immediatamente a tutti che Google non sta perdendo terreno e rimane una delle aziende leader nel campo delle tecnologie di intelligenza artificiale.

I modelli e i prodotti AI come Bard di Google o ChatGPT di OpenAI, alimentati dai chip Nvidia A100, richiedono un gran numero di computer e migliaia di chip condivisi per addestrare ed eseguire modelli AI. Questi computer funzionano 24 ore su 24 per molte settimane o addirittura mesi per completare l’addestramento, il che impone sicuramente qualche inconveniente.

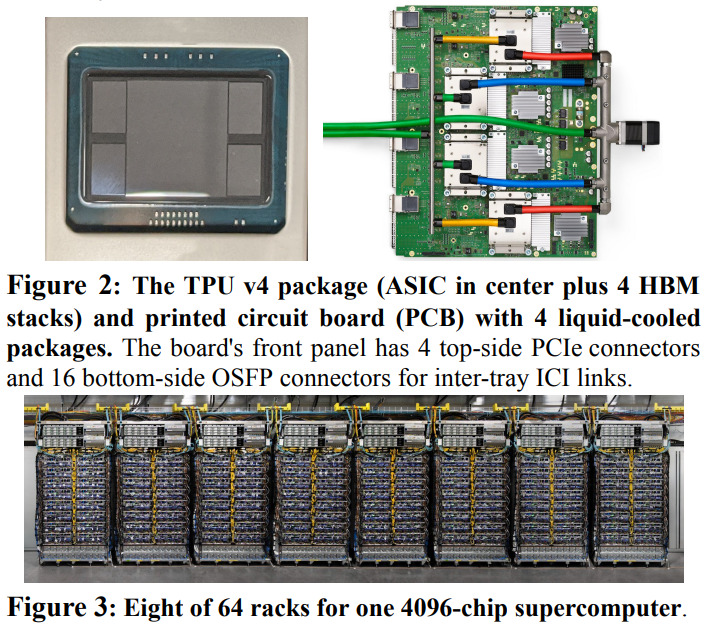

Martedì scorso, Google ha annunciato di aver creato un unico sistema con oltre 4.000 processori, progettato per funzionare in modo efficiente e per addestrare rapidamente modelli di intelligenza artificiale. Il supercomputer basato sulle TPU di Google, chiamato TPU v4, è “da 1,2 a 1,7 volte più veloce e consuma da 1,3 a 1,9 volte meno energia rispetto a Nvidia A100.

“Prestazioni, scalabilità e convenienza rendono i supercomputer TPU v4 cavalli di battaglia da utilizzare in combinazione con modelli di linguaggio di grandi dimensioni”, scrivono i ricercatori di Google.

Tuttavia, i punteggi dei test dei nuovi chip di Google non sono stati confrontati con l’ultimo chip H100 di Nvidia. È più moderno e, molto probabilmente, aggirerà i chip di Google su tutti i fronti.

Secondo Nvidia, l’H100 offre almeno 4 volte le prestazioni della generazione precedente. Tuttavia, mentre Nvidia finora ha appena mostrato il nuovo chip, Google ha già presentato un supercomputer già pronto con la sua tecnologia. Per il momento Google è avanti, ma la situazione potrebbe cambiare radicalmente se Nvidia presenterà il proprio supercomputer nel prossimo futuro.

La notevole quantità di potenza di calcolo richiesta per l’intelligenza artificiale non è affatto economica, motivo per cui molte aziende del settore, come Google e Nvidia, si stanno concentrando sullo sviluppo di nuovi chip, componenti, tecnologie software e persino i suddetti supercomputer per poter ridurre il costo delle tecnologie necessarie per l’apprendimento e il funzionamento dell’intelligenza artificiale e delle reti neurali.

Anche i requisiti di alimentazione per l’intelligenza artificiale sono ancora estremamente elevati, il che è una sorta di sbocco per fornitori di servizi cloud come Google, Microsoft e Amazon, che affittano la loro potenza di calcolo a ore e ci guadagneranno molto bene. Ad esempio, Google ha recentemente rivelato che l’ultima versione del famigerato generatore di immagini Midjourney AI è stata addestrata sui suoi chip TPU.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.