Il Google Threat Intelligence Group (GTIG) ha pubblicato un rapporto che descrive in dettaglio l’abuso diffuso del modello linguistico Gemini.

Secondo l’azienda, gli aggressori utilizzano l’intelligenza artificiale in ogni fase dei loro attacchi, dalla ricognizione all’esfiltrazione dei dati. Inoltre, alcuni gruppi stanno tentando di clonare il modello stesso tramite distillazione, generando 100.000 query.

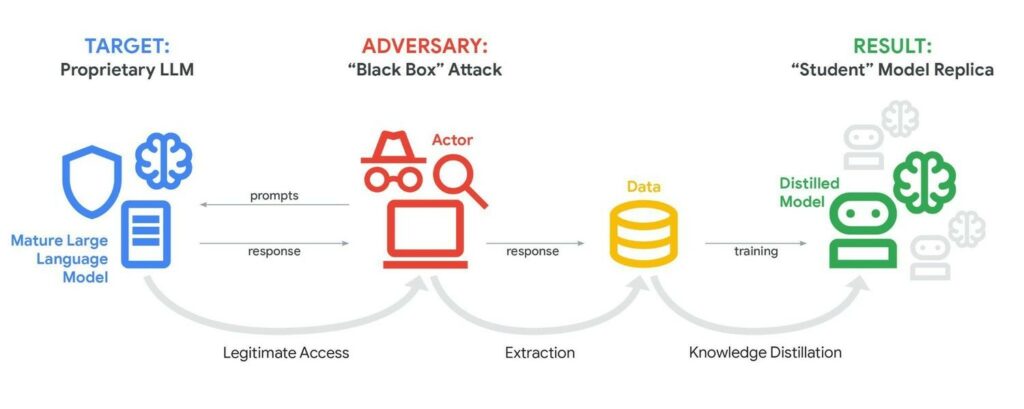

Gli analisti di Google segnalano di aver rilevato tentativi di estrarre informazioni da Gemini tramite query di massa. In un caso, gli aggressori hanno inviato al modello oltre 100.000 prompt in diverse lingue, raccogliendo le risposte per addestrare una propria copia più economica, che replica i processi decisionali del modello per simularne la funzionalità.

Questa pratica, chiamata distillazione, rappresenta una seria sfida commerciale e competitiva per la protezione della proprietà intellettuale. Il principio è semplice: invece di spendere miliardi di dollari e anni per addestrare il proprio LLM, gli aggressori cercano di utilizzare un modello esistente come scorciatoia.

Gli aggressori bombardano Gemini con migliaia di prompt accuratamente selezionati, raccolgono tutte le risposte e quindi utilizzano i dati risultanti per addestrare un modello più piccolo ed economico.

Gli esperti del GTIG sottolineano inoltre che i gruppi di hacker “governativi” provenienti da Cina (APT31, Temp.HEX), Iran (APT42), Corea del Nord (UNC2970) e Russia utilizzano attivamente Gemini per supportare tutte le fasi dei loro attacchi, dalla ricognizione e creazione di esche di phishing allo sviluppo di infrastrutture di controllo e furto di dati.

Ad esempio, alcuni hacker cinesi si sono spacciati per esperti di sicurezza informatica per chiedere a Gemini di automatizzare l’analisi delle vulnerabilità e fornire piani di test mirati per uno scenario fittizio. Google osserva che un gruppo ha testato il toolkit Hexstrike MCP e ha chiesto al modello di analizzare l’esecuzione di codice remoto, le tecniche di elusione WAF e gli attacchi di SQL injection contro specifici obiettivi americani.

A sua volta, l’APT42 iraniano ha utilizzato LLM per l’ingegneria sociale e come piattaforma per accelerare la creazione di strumenti malware personalizzati, dal debug alla generazione di codice e all’apprendimento di tecniche di sfruttamento.

Gli analisti hanno anche documentato l’uso dell’intelligenza artificiale per introdurre nuove funzionalità nelle famiglie di malware esistenti, tra cui il kit di phishing CoinBait e il downloader di malware HonestCue.

CoinBait è un kit di phishing racchiuso in una React SPA e mascherato da exchange di criptovalute per raccogliere credenziali. Gli artefatti nel codice indicano che è stato sviluppato utilizzando l’intelligenza artificiale. Ad esempio, un indicatore dell’utilizzo di LLM sono i messaggi con il prefisso “Analytics:”.

I ricercatori del GTIG ritengono che questo malware sia stato creato utilizzando la piattaforma Lovable AI, poiché lo sviluppatore ha utilizzato il client Lovable Supabase e l’applicazione lovable.app.

Il caricatore HonestCue, a sua volta, è un framework PoC che utilizza l’API Gemini per generare codice C# per la seconda fase del malware, per poi compilare ed eseguire i payload in memoria.

Gli specialisti di Google sottolineano di aver già bloccato gli account e l’infrastruttura di tutti gli aggressori identificati e di aver implementato nuove misure di sicurezza nei classificatori per rendere più difficili attacchi simili in futuro.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.