Autore: Olivia Terragni

Oggi, l’aiuto tecnico e strategico dell’Intelligenza artificiale (IA) per la cyber security, è essenziale per rendere i sistemi più robusti contro gli attacchi e identificare velocemente vulnerabilità che spesso sfuggono agli “esperti umani”.

Questa tecnologia rappresenta anche un vantaggio competitivo continuo – per le nazioni e per le organizzazioni- nuove possibilità in tema di difesa per l’intelligence, la ricognizione e la sorveglianza e la capacità di accedere in modo molto veloce alle informazioni e ai dati.

Secondo il Capgemini Research Institute, il 69% delle organizzazioni, ritiene l‘intelligenza artificiale fondamentale per il futuro della sicurezza informatica e che, senza di lei, non sarà in grado di contrastare le nuove minacce informatiche, che causeranno perdite sempre più costose.

Tra queste chi non l’ha ancora introdotta intende farlo nel più breve tempo possibile. Tutto ciò però include un complesso lavoro a monte per stabilire una corretta governance, nel formare i cyber analisti, per identificare al meglio le fonti dei dati e creare piattaforme per rendere operativa l’IA.

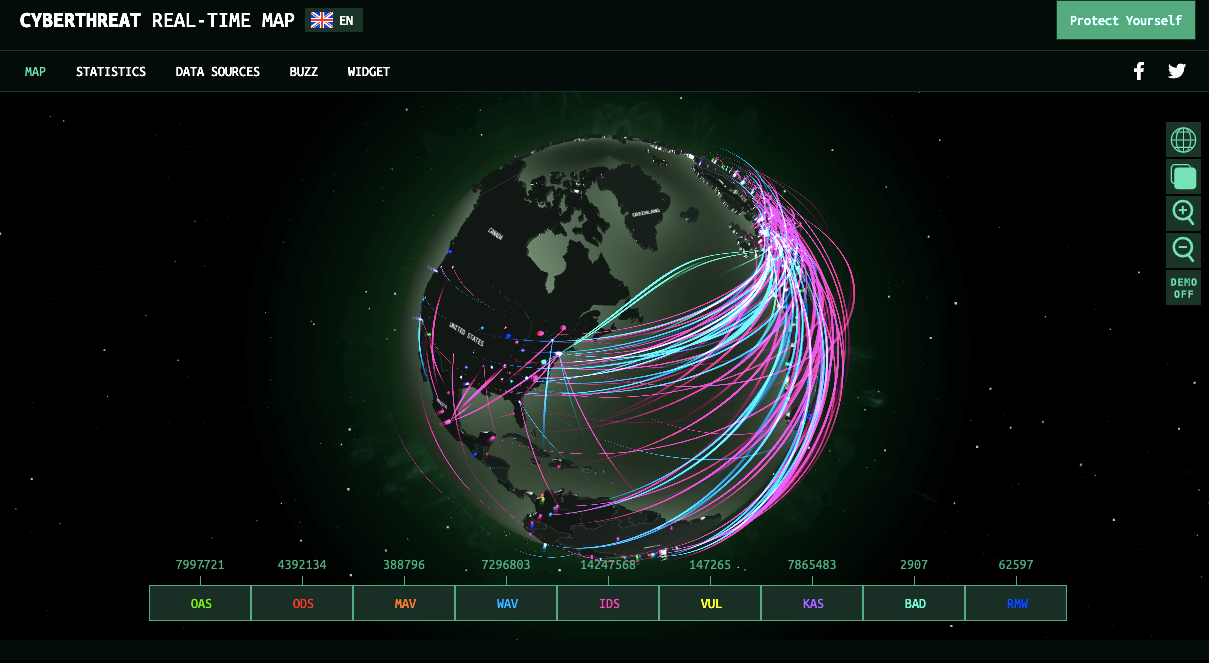

Dal Gennaio 2019 all’Aprile del 2020, secondo quanto rilevato da Enisa (Agenzia dell’Unione europea per la cyber sicurezza) in Europa e nel mondo le minacce sono aumentate in modo esponenziale, tra exploit, furto di credenziali, violazioni di dati e attacchi informatici.

Le tecniche utilizzate più di frequente per avviare un attacco informatico includono la forza bruta con credenziali rubate, ingegneria sociale, errori di configurazione e sfruttamento di applicazioni web.

La mancata correzione delle vulnerabilità ha provocato e provoca ancora gravi ripercussioni. Pensiamo solo quanto è successo durante la pandemia di Covid-19: i cyber criminali e i ransomware in aumento – anche se già elevati prima – hanno messo sotto pressione le organizzazioni sanitarie trasformandole in uno dei settori più critici da proteggere.

Il malware – diffuso soprattutto tramite eMail di spam dannose e phishing – è diventato una delle 15 principali minacce e in alcuni casi – ancora nel 2021 – molti sistemi non sono ancora in grado di rilevarlo.

Anche se viene migliorata la capacità di rilevamento, la natura porosa del cyber spazio, ove l’attribuzione dell’attaccante è ancora difficile e non importa quanti sforzi, tempo e soldi si investono nella difesa, l’attacco prima o poi avrà successo.

Le minacce informatiche, difatti, non rimangono mai le stesse per molto tempo. Ce ne sono milioni che vengono create ogni anno e tutte diventano più potenti delle precedenti.

A ciò si aggiungono gli attacchi alla supply chain informatica – hardware, software, cloud, applicazioni web e così via – cresciuti in numero e complessità nel 2020 e di cui si è stimato un aumento di 4 volte superiore nel 2021.

E’ indubbio che l’intelligenza artificiale in questo panorama può giocare un ruolo chiave, che è quello di supportare la cyber security tecnicamente e strategicamente, rendendo i sistemi più robusti agli attacchi.

Tecnologia unica, interattiva ed autonoma, l’IA impara ad adattarsi all’ambiente ed è in grado di portare a termine compiti che altrimenti richiederebbero il nostro intervento, riuscendo a prevedere le minacce e identificare le anomalie con una precisione e una velocità molto maggiori rispetto a quella dell’uomo.

L’IA, inoltre, che procede nel suo compito di rilevamento in base a moltissimi dati – sui quali è stata allenata – prende decisioni informate, determinando se le anomalie rilevate siano dannose o meno.

Tuttavia, nel 2021 – questa forma di intelligenza, ancora lontana dall’essere intuitiva – è ancora una tecnologia incompleta e rivela eventi involontari e intenzionali che rendono molto difficile la previsione dei suoi comportamenti che possono diventare instabili e pericolosi.

Ciò impone delle sfide etiche, per le quali sarebbe utile intervenire nel momento in cui questa tecnologia è ancora ai suoi albori. In lista regole normative che agiscano per attenuare la mancanza di controllo, obiettivi legittimi e comportamento responsabile.

Nel caso della cyber security, inoltre bisogna infatti essere consapevoli della differenza tra obiettivi immediati e punti di vista a lungo termine – sfide – quando si tratta delle tecniche di intelligenza artificiale nella prevenzione degli attacchi informatici, che richiedono spesso misure più complesse o “sofisticate”.

Ad individuare tre grandi aree di “impatto” e le seguenti sfide etiche è Mariarosaria Taddeo – ricercatrice all’Oxford Internet Institute e vicedirettore del Digital Ethics Lab – in “Three Ethical Challenges of Applications of Artificial Intelligence in Cybersecurity”:

Analizziamo i tre campi.

Nel primo caso, ove la robustezza corrisponde alla capacità di un sistema di continuare a funzionare, e rispondere a diversi gradi di disturbo – oltre a poter prevedere in modo esaustivo gli input e gli output erronei – Taddeo impone una riflessione etica assolutamente giustificata. Se da una parte, l’IA può aiutare con la verifica e la convalida dei software – riducendo il valore di exploit e zero-day – dall’altra parte dobbiamo pensare al rischio di dequalificazione dell’uomo che oggi porta a termine a tale compito, oltre al rischio potenziale di prendere il controllo in caso di errore della macchina. Quindi l’ovvia conclusione – allo stato dei fatti – è la necessaria presenza dell’uomo nell’intero processo, a partire dagli input dei dati ad arrivare al suo continuo monitoraggio.

Sapete quando si dice che non importa quanto bene sia progettato un sistema, la realtà prima o poi cospirerà per distruggere il sistema?

Nasce poi la successiva domanda: l’IA è in grado continuare a svolgere la sua missione di fronte alle avversità?

Taddeo prende l’esempio di un potenziale uso estensivo e completo di dati esponendo la privacy degli utenti che porterebbe all’effetto “sorveglianza di massa” tramite il controllo estensivo su autenticazione degli utenti, monitoraggio del loro il comportamento e generazione di profili biometrici.

Sapete quando si dice ultima ma non meno importante? La risposta del sistema è delle sfide più urgenti per la stabilità del cyberspazio perché include sistemi di cybersecurity autonomi. L’IA, in grado di migliorare le misure di risposta e di contrasto, allo stesso tempo può ampliare la capacità di mira degli aggressori. In che modo? Offrendo nuovi mezzi per sferrare un attacco, quindi fornendo agli aggressori la possibilità di utilizzare attacchi più complessi.

A queste tre sfide si aggiungono inoltre tutta una serie di problematiche collegate al ruolo dell’essere umano e il successivo controllo consapevole sulla macchina:erosione dell’autodeterminazione umana, svalutazione delle capacità umane, decisioni incomprensibili della macchina in termini morali, riduzione del controllo umano e delle sue responsabilità e quindi l’abilitazione alla

macchina di potere nuocere e quindi fare del male (in assenza attuale di una coscienza).

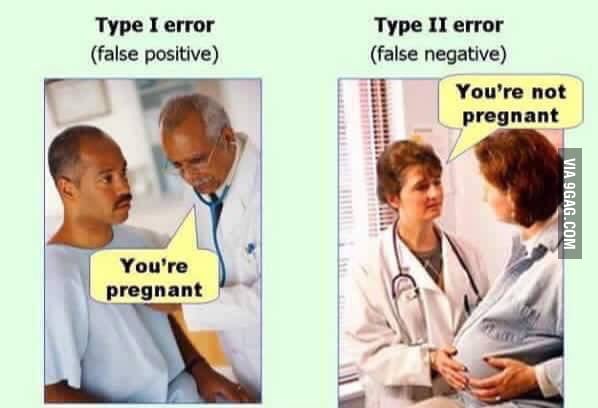

Concludiamo con la piaga dei falsi postivi. L’immagine parla da sé: in medicina i falsi positivi sono errori abbastanza costosi per non dire altro: nella cyber security trovare l’equilibrio tra ignorare ciò che non importa e riconoscere tutto ciò che invece lo è, rimane una questione chiave allo stesso modo importante.

Il problema è che attualmente l’IA e ogni sistema basato su Machine Learning (ML) non è inattaccabile: anche se continua e continua ad imparare diventando esperto è ancora vulnerabile a falsi attacchi, progettati per suscitare molti falsi positivi e che hanno l’intento di fargli classificare gli esempi benigni come dannosi.

Tra le soluzioni vi è quella di aumentare il livello di sforzo richiesto dall’attacco avversario nell’avvelenare i dati. Ma il problema fondamentale rilevato da Stefano Pollini è che Il problema che sta nell’evitare sia i falsi positivi che i falsi negativi, però, è che più si lavora per evitare uno e più si rischia di cadere nell’altro.

Questo significa che il rischio zero non può essere impostato.

(Un problema etica e collegato ai limiti intrinseci di ogni progetto di Intelligenza Artificiale èrappresentato dall’incidente automobilistico di Uber, quando l’auto a guida autonoma non fece in tempo a

rilevare un pedone e quindi a frenare, alla fine travolgendolo, il 18 marzo 2018).

“Ricordo ancora il primo giorno che mi sono imbattuto in Internet. Era il 1993, quando ero al liceo. Andai a trovare – con un paio di ragazzi – il nostro amico Ido.

Volevamo giocare a ping pong. Ido era già una grande fan del computer e invece di aprire il tavolo da gioco, lui insistette nel mostrarci l’ultima meraviglia. Connettè il cavo del telefono al computer e digitò su alcuni tasti. Per qualche momento tutto quello che potevamo sentire erano squeacks, shrieks e buzzes, poi il silenzio. Non riuscì nel suo intento. Noi borbottavamo, e Ido provò ancora. Ancora ed ancora. Alla fine fece un urlo, annunciando che aveva appena connesso il suo computer al computer centrale dell’università vicina.

“E cosa c’è sul computer centrale?” chiedemmo.

“Ebbene” ammise “Non c’è ancora nulla, ma tu puoi metterci qualsiasi cosa”.

“Qualsiasi cosa, cosa?” chiedemmo.

“Non lo so, ogni tipo di cosa”.

Non sembrò molto promettente. Andammo così a giocare a ping pong, e per le settimane seguenti godemmo di un nuovo passatempo, prendendo in giro la ridicola idea di Ido” Yuval Noah Harari, Homo Deus

Quando parliamo di intelligenza artificiale allo stato attuale possiamo pensare a qualcosa di imperscrutabile, così come poteva essere un server per un adolescente Yuval Hoah Harari. “E cosa c’è sul computer centrale?”

Un’IA non solo è imperscrutabile, ma può imparare da sola, ed è difficile prevederne il comportamento e sapere se funzionerà o meno al 100%. Dato ciò, la sua regolamentazione e il suo monitoraggio – prima, durante e dopo la sua progettazione – potrebbe essere l’unico modo in cui tenerla sotto controllo.

La vera sfida sarà capirsi a vicenda, anche se quello che conterrà una “macchina intelligente” dipenderà da noi.

Per comprendere il grado di sviluppo dell’intelligenza artificiale in tema di difesa, se negli Stati Uniti (US) l’IA viene utilizzata per aumentare l’efficienza, la precisone, la mobilità e la capacità delle operazioni, in Europa invece l’utilizzo dell’intelligenza artificiale ai fini della difesa è allo stato embrionale, soprattutto per quanto riguarda l’integrazione di soluzioni nella complessa rete dei sistemi legacy.

Sempre in ambito militare, vengono utilizzati sensori di rete intelligenti e prototipi per rilevare segnali biometrici – per bersagli ad alto valore – moltiplicano le prestazioni per le operazioni speciali, consentono di analizzare i sentimenti della popolazione con cui il corpo militare entra in contatto, migliorando il processo decisionale e le abilità cognitive.

Quindi in conclusione, la domanda è sempre: potremo mai lasciare all’IA la scelta di decidere? Pensiamo al caso di un edificio target durante ad un’operazione militare: quanti bambini potrebbero trovarsi li dentro e come distinguerli?

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…