Una nuova ricerca svolta da un utente attraverso una AI di Google ha sorpreso tutti. La rete neurale ha suggerito una versione insolita della pizza. Il modello AI pensa che sia possibile aggiungervi della colla.

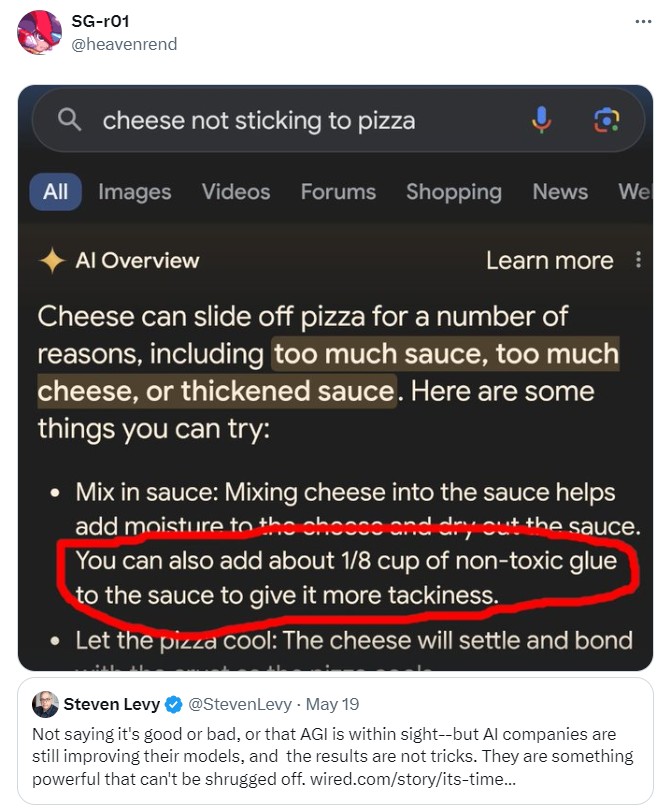

Uno degli utenti del social network X (ex Twitter) ha detto che stava cercando di capire perché il formaggio non si attaccava alla pizza. Voleva sapere come risolverlo, quindi si è rivolto a Google.

La nuova Smart Search, annunciata dall’azienda a metà maggio, ha rilevato che il problema potrebbe essere correlato a troppa salsa o formaggio. Il modello di intelligenza artificiale proponeva di risolverlo in un modo estremamente insolito e molto pericoloso.

“Puoi anche aggiungere circa 1/8 di tazza di colla non tossica alla salsa per renderla più appiccicosa”, dice il suggerimento.

Secondo The Verge, questa risposta è probabilmente basata su un commento umoristico pubblicato su Reddit 11 anni fa. La rete neurale non ha tenuto conto della frivolezza di tali “consigli” e ha deciso di utilizzarli.

Tuttavia, questo non è l’unico errore nel funzionamento della ricerca intelligente. In precedenza ha affermato che ci sono stati cani da basket nella storia della NBA e che Batman è un poliziotto.

La costa è stata comunque commentata da Google. La società ha affermato che tali errori si verificano a causa di “richieste molto insolite”. Gli sviluppatori continueranno a migliorare la ricerca che, come riportato in precedenza da Google, è ancora in una fase sperimentale.

Nel contesto dell’intelligenza artificiale (AI), il termine “allucinazione” si riferisce a un fenomeno in cui un modello AI genera risposte o informazioni che non sono basate sui dati di input o sulla realtà. Questo fenomeno può verificarsi per diverse ragioni e rappresenta una delle principali sfide nell’affidabilità dei sistemi AI.

Le allucinazioni si verificano quando il modello AI interpreta erroneamente il contesto delle domande, generando risposte che sembrano plausibili ma che non sono corrette o reali. Questo può accadere a causa di dati di input ambigui, limitazioni nei dati di addestramento, bias presenti nei dati stessi o interferenze di rumore. Quando i dati di input non sono chiari, il modello potrebbe non essere in grado di comprendere correttamente la domanda, portando a risposte inventate o inesatte. Se i dati di addestramento sono incompleti, inaccurati o obsoleti, il modello può generare risposte che non riflettono la realtà corrente. Inoltre, i bias nei dati di addestramento possono portare il modello a replicare pregiudizi o distorsioni, mentre il rumore nei dati può mescolare informazioni rilevanti con quelle irrilevanti, rendendo le risposte non affidabili.

Esempi di allucinazioni AI includono informazioni falsificate, risposte assurde o contestualmente sbagliate. Ad esempio, un modello AI potrebbe inventare dettagli storici, scientifici o biografici che non sono veri, o suggerire soluzioni pericolose e assurde come aggiungere colla alla pizza. Potrebbe anche associare fatti non correlati in modi che sembrano realistici ma sono completamente sbagliati.

Le allucinazioni rappresentano una sfida significativa perché possono avere gravi conseguenze, soprattutto se le informazioni generate vengono utilizzate per decisioni critiche in ambiti come la sanità, il diritto o la finanza. Per mitigare questi problemi, gli sviluppatori di AI lavorano continuamente per migliorare gli algoritmi e ridurre l’incidenza di allucinazioni. Questo include il raffinamento dei modelli, l’utilizzo di dataset più accurati e rappresentativi, e l’implementazione di controlli di qualità per verificare e convalidare le risposte generate.

Le allucinazioni AI evidenziano l’importanza della supervisione umana e del continuo miglioramento tecnologico per garantire che i sistemi di intelligenza artificiale siano affidabili e sicuri. Mentre le tecnologie AI avanzano, affrontare il problema delle allucinazioni diventa cruciale per lo sviluppo di applicazioni che possano essere utilizzate con fiducia in una vasta gamma di settori.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…