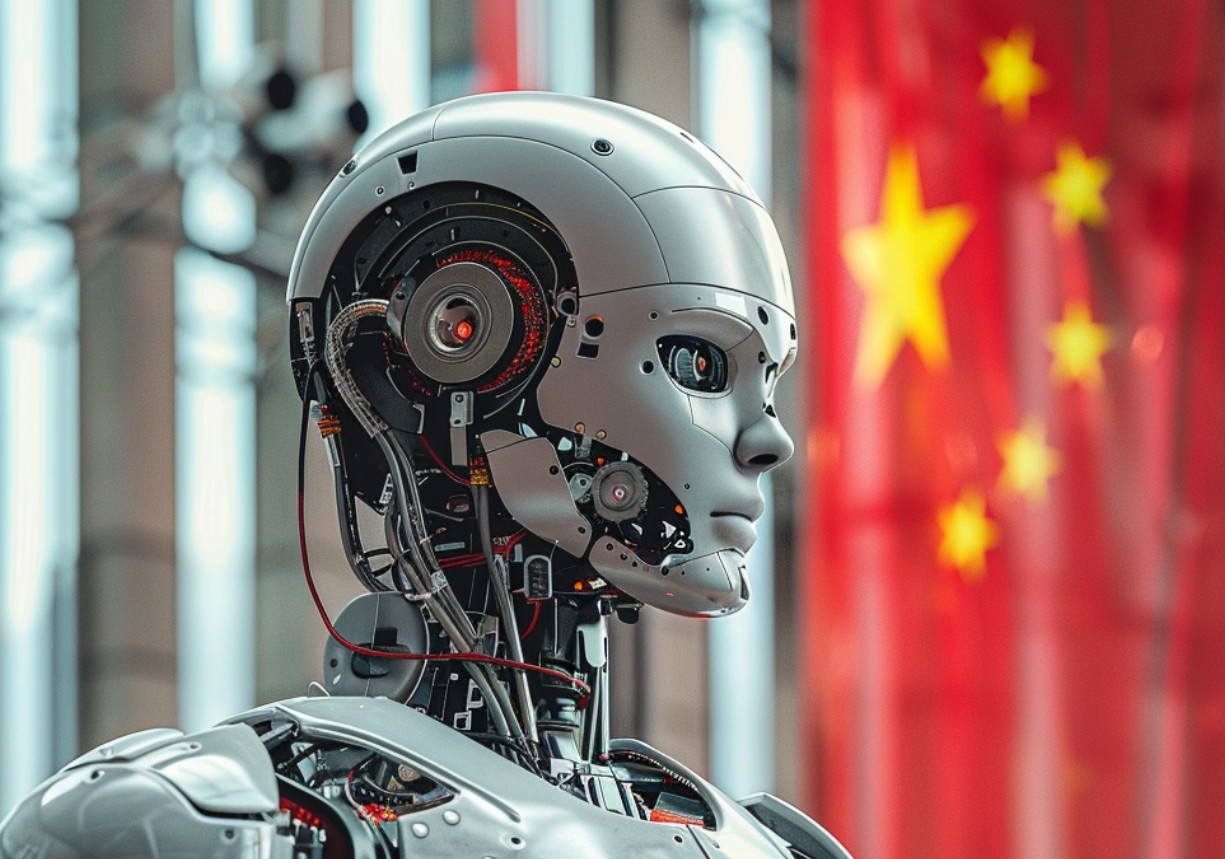

Gli istituti di ricerca cinesi affiliati all’Esercito popolare di liberazione (PLA) hanno iniziato a utilizzare il modello Llama 2 di Meta per sviluppare il proprio strumento di intelligenza artificiale (AI) per applicazioni di difesa e polizia. La ricerca mostra che il modello Llama 2, originariamente disponibile di pubblico dominio, è diventato la base per la creazione di un’intelligenza artificiale militarizzata nota come ChatBIT.

A giugno, scienziati cinesi di tre diverse istituzioni, tra cui l’Accademia delle scienze militari del PLA, hanno pubblicato un articolo in cui descrivevano come avevano adattato il modello Llama per scopi di raccolta e analisi di intelligence. La loro versione è stata ottimizzata per il dialogo e per rispondere a domande volte a supportare le decisioni operative in ambito militare. Secondo lo studio, ChatBIT mostra livelli di prestazioni simili a ChatGPT-4 di OpenAI.

Gli sviluppatori del progetto sottolineano che ChatBIT contiene finora solo 100mila registrazioni di dialoghi militari, un numero relativamente piccolo rispetto ad altri modelli linguistici. Tuttavia, stanno pianificando un ulteriore sviluppo per utilizzare ChatBIT per la pianificazione strategica, la modellazione e il supporto decisionale del team.

Inoltre, la Cina utilizza attivamente l’intelligenza artificiale per scopi di sicurezza interna. Altri studi rilevano che il modello di Llama è già stato utilizzato per analizzare i dati relativi alle esigenze della polizia per migliorare il processo decisionale in materia di sicurezza pubblica. Ad aprile, la pubblicazione statale PLA Daily ha evidenziato come l’intelligenza artificiale potrebbe accelerare lo sviluppo delle armi, migliorare le simulazioni di combattimento e migliorare l’efficienza dell’addestramento militare.

Gli esperti occidentali sottolineano che l’uso delle tecnologie di intelligenza artificiale occidentali da parte di specialisti cinesi può contribuire a ridurre il divario tecnologico tra Cina e Stati Uniti. Ad esempio, la società cinese AVIC, affiliata al PLA, ha utilizzato Llama 2 per sviluppare strategie di contromisure elettroniche aviotrasportate.

Meta, a sua volta, ha una politica di libero accesso ai suoi modelli di intelligenza artificiale, ma impone alcune restrizioni, vietando l’uso di queste tecnologie per scopi militari, di intelligence o nucleari. Tuttavia, a causa della natura pubblica di questi modelli, l’applicazione delle condizioni d’uso rimane limitata.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…