Durante una RHC Conference, Corrado Giustozzi sottolineò una verità tanto semplice quanto potente: “L’essere umano è, da sempre, un creatore di amplificatori.”. Dalla ruota alla macchina, ogni invenzione ha avuto uno scopo preciso: fare meglio, fare prima. Abbiamo trasformato ore in minuti, giorni in istanti. Abbiamo guadagnato tempo, efficienza, velocità.

Ma tutto questo… a quale prezzo?

Nel contesto degli strumenti AI emergenti, il Massachusetts Institute of Technology (MIT) ha svolto uno studio su come l’impiego ripetuto di ChatGPT per scrivere saggi possa generare una forma di “debito cognitivo” rilevando una riduzione della capacità di ragionamento autentico e doti analitiche personali.

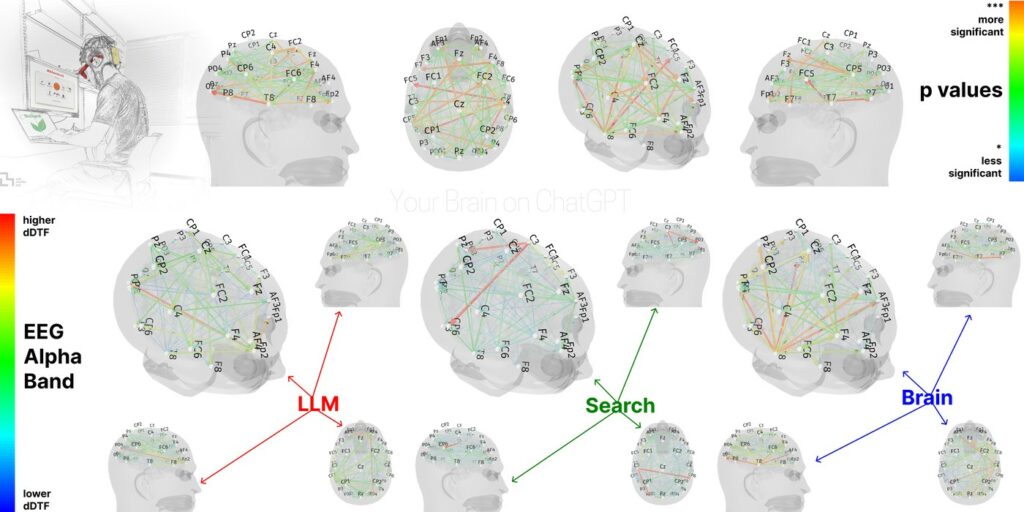

La ricerca del MIT ha coinvolto 54 partecipanti in diverse condizioni sperimentali—scrittura autonoma, assistita da motori di ricerca tradizionali e affidata all’intelligenza artificiale—con l’obiettivo di quantificare l’impatto neuro-cognitivo di ciascun approccio .

I dati raccolti tramite elettroencefalografia hanno rivelato che la scrittura completamente autonoma stimola la connettività cerebrale più robusta e distribuita, seguita dall’uso di Google. Al contrario, l’utilizzo di ChatGPT ha mostrato una connettività più debole, in particolare nelle bande alfa e beta, segno di uno sforzo cognitivo ridotto. Ciò suggerisce che l’assistente AI alleggerisce il carico mentale, ma a discapito del coinvolgimento attivo del cervello.

Quando i partecipanti hanno invertito l’esperienza, passando dall’AI alla scrittura autonoma, l’EEG ha evidenziato che la connettività rimaneva depressa. Questo indica che l’esposizione all’IA può avere effetti duraturi sulla capacità cognitiva, compromettendo la prontezza mentale anche dopo l’interruzione dell’uso dell’assistente.

Sul piano delle competenze linguistiche e mnemoniche, i soggetti hanno avuto difficoltà a citare correttamente parti del testo creato con l’AI, con tassi di errore molto più elevati rispetto agli altri due gruppi, e segnalando anche una minore percezione di proprietà del lavoro. I testi prodotti con ChatGPT mostravano inoltre una minore diversità lessicale e strutturale .

Le implicazioni educative emerse da questo lavoro sono rilevanti: l’uso precoce e ripetuto di intelligenze artificiali per compiti che richiedono sforzo cognitivo può indurre una sorta di dipendenza, riducendo la capacità autonoma di pensiero. Gli autori suggeriscono che l’AI debba essere impiegata come uno strumento di supporto, non come sostituto, preferibilmente dopo che lo studente abbia esercitato le proprie abilità in modo indipendente .

Accanto all’impatto cognitivo, viene sollevato anche il tema ambientale: l’uso di modelli AI come ChatGPT richiede consumi energetici e risorse computazionali significativamente superiori alle ricerche web standard, incrementando il “debito” anche a livello ecologico . In sintesi, lo studio mette in luce che, nonostante i vantaggi pratici, un uso non strutturato dell’AI può comprometterne la funzione didattica, rendendo necessario un approccio pedagogico bilanciato e consapevole.

Lo studio puntualizza e afferma che usare ChatGPT non ci fa diventare stupidi, ma afferma che se usi troppo gli assistenti AI per fare il lavoro al posto tuo, non imparerai nulla.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…