Articolo di: Ilaria Montoro

Data Pubblicazione: 26/02/2021

La domanda da cui vorrei partire è:

Cosa succede alle fondamenta della democrazia quando si sposa con le nuove tecnologie fino a diventare impossibile delinearne i confini?

Il progresso irrompe, non chiede permesso.

E nel contesto attuale tracciare il nuovo rapporto tra esseri umani e macchine non è affatto semplice.

Anche il diritto penale si deve quindi, attrezzare per tenere il passo di questa rapidissima evoluzione tecnologica, per non rischiare di soccombere di fronte a quello che si preannuncia essere un nuovo, sconvolgente «shock da modernità», che comporterà il verificare l’idoneità delle norme esistenti all’applicarsi delle nuove tecnologie, così da valutare se sia opportuno, per i legislatori, coniare delle regole ad hoc.

“Questo non sono io”, ha detto agli investigatori Robert Julian-Borchak Williams.

“Pensi che tutti gli uomini neri si assomiglino?”

Robert Julian-Borchak Williams

Un giovedì pomeriggio di gennaio, Robert Julian-Borchak Williams terminata la sua giornata di lavoro, entrato nel suo vialetto in una tranquilla suddivisione a Farmington Hills, Michigan, un’auto della polizia si fermò dietro, bloccandolo. Due agenti scesero e ammanettarono il signor Williams sul prato davanti a sua moglie e le due giovani figlie.

Sua moglie, Melissa, chiese dove fosse stato portato.

“Cercalo su Google”, ricorda un agente che rispondeva.

La polizia ha portato il signor Williams in un centro di detenzione.

Ha ricevuto la sua foto segnaletica, le impronte digitali, il DNA, ed è stato trattenuto durante la notte. Verso mezzogiorno di venerdì, due detective lo hanno portato in una stanza degli interrogatori e hanno messo tre fogli di carta sul tavolo, a testa in giù. L’investigatore voltò il primo pezzo di carta. Era un fermo immagine di un video di sorveglianza, che mostrava un uomo massiccio, vestito di nero e con un berretto rosso dei St. Louis Cardinals, in piedi di fronte a un display di orologi.

Cinque segnatempo, del valore di 3.800 dollari, sono stati rubati.

“Sei tu?” chiese il detective.

Il signor Williams sapeva di non aver commesso il crimine in questione.

Quel che non poteva sapere, mentre sedeva nella stanza degli interrogatori, è che il suo caso potrebbe essere il primo resoconto noto di un americano arrestato ingiustamente sulla base di una corrispondenza difettosa da un algoritmo di riconoscimento facciale.

I sistemi di riconoscimento facciale sono stati utilizzati dalle forze di polizia per più di due decenni. Recenti studi del MIT e del NIST (National Institute of Standards and Technology), hanno scoperto che mentre la tecnologia funziona relativamente bene sugli uomini bianchi, i risultati sono meno accurati per altri dati demografici, in parte a causa della mancanza di diversità nelle immagini utilizzate per sviluppare i database sottostanti.

Una portavoce della polizia di Detroit, Nicole Kirkwood, ha affermato che per ora il dipartimento “ha accettato la decisione del pubblico ministero di archiviare il caso”. Ha anche affermato che il dipartimento ha aggiornato la sua politica sul riconoscimento facciale nel luglio 2019 in modo che venga utilizzata solo per indagare su crimini violenti.

Clare Garvie

Clare Garvie, avvocato presso il Center on Privacy and Technology della Georgetown University, ha scritto sui problemi con l’ uso del riconoscimento facciale da parte del governo. Sostiene che le immagini di ricerca di bassa qualità, come un’immagine fissa da un video di sorveglianza granuloso, dovrebbero essere vietate e che i sistemi attualmente in uso dovrebbero essere rigorosamente testati per accuratezza e distorsione.

Il suo arresto indica un problema molto più grande di uso eccessivo di algoritmi inaffidabili da parte della polizia.

A partire dal 2019, il Dipartimento di Correzione dell’Arizona investì più di 24 milioni di dollari contrattando con la società IT Business & Decision, Nord America, per costruire e mantenere il programma software, noto come ACIS (Arizona Correctional Information System), utilizzato per gestire la popolazione di detenuti nelle carceri statali.

Uno dei moduli software all’interno di ACIS, progettato per calcolare le date di rilascio dei detenuti, non è attualmente in grado di tenere conto di un emendamento alla legge statale approvato nel 2019. Il Senate Bill 1310 , infatti, redatto dall’ex senatore Eddie Farnsworth, ha emendato gli Statuti rivisti dell’Arizona in modo che alcuni detenuti condannati per reati non violenti potessero guadagnare ulteriori crediti di rilascio al termine della programmazione nelle carceri statali.

Carcere di stato Florence in Arizona

Ma fonti del dipartimento dicono che il software ACIS non è ancora in grado di identificare i detenuti che si qualificano per la programmazione SB 1310, né può calcolare le loro nuove date di rilascio al termine della programmazione, riscontrando più di 14.000 bug da quando è stato implementato nel novembre 2019.

Anche se i detenuti vengono identificati e sono in grado di completare la programmazione richiesta per le versioni di SB 1310, “Non riusciamo a trovare persone che li inseriscano nei programmi, e dopo aver completato i programmi, non possiamo ancora farli uscire dalla porta”, riferisce una fonte. “Queste persone sono letteralmente intrappolate”.

L’audit afferma: “Durante la migrazione dei dati da AIMS (in funzione da più di tre decenni), molti record che non avrebbero dovuti essere trasferiti al nuovo sistema lo sono invece stati, causando complicazioni e molto lavoro manuale per risolvere i problemi di conversione. Come con qualsiasi nuovo sistema, la mancanza di sufficiente conoscenza ed esperienza del personale, ha portato ad errori di pubblicazione che ritardano e complicano ulteriormente il processo di riconciliazione”.

Precisamente, hanno stimato che la correzione del bug SB 1310 richiederebbe circa 2.000 ore di programmazione aggiuntive.

In risposta a questo rapporto, un portavoce del Dipartimento di Correzione ha dichiarato che ciò non ha ritardato il rilascio di eventuali detenuti, ma ha ammesso che il sistema ACIS “attualmente non calcola le date di rilascio in conformità con i parametri stabiliti dal Senate Bill (SB) 1310. Ad oggi sono state identificate manualmente 733 persone che potrebbero qualificarsi, ma non sono attualmente registrate in alcun programma di detenzione”.

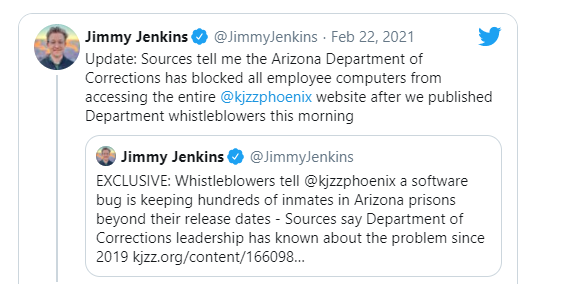

Il giornalista della giustizia penale Jimmy Jenkins, che per primo ha svelato la storia, ha twittato il 22 febbraio 2021 che il Dipartimento di Correzione dell’Arizona ha bloccato l’accesso di tutti i dipendenti al sito Web KJZZ .

Applicazioni di questo tipo, pertanto, andrebbero monitorate accuratamente, anche dal punto di vista giuridico, al fine di elaborare un preciso quadro normativo che ne regoli il legittimo utilizzo, nel rispetto dei diritti fondamentali delle persone.

Probabilmente molti di noi ricordano la figura di RoboCop, il poliziotto con un corpo di titanio e kevlar, un cervello informatico e sensori ultrapotenti: se nel 1987, anno di uscita del celebre film, tale immagine apparteneva decisamente alla fantascienza, oggi la realtà ci propone alcune applicazioni delle tecnologie diIA – in uso, per lo più in via sperimentale, presso le forze di polizia di alcuni Stati – che si avvicinano molto a RoboCop: si tratta, nella maggior parte dei casi, di macchine robotiche, non necessariamente umanoidi, utilizzate per una varietà di compiti, come ad esempio attività di pattugliamento, sorveglianza, disinnesco di bombe, individuazione di atteggiamenti sospetti, riconoscimento facciale, etc.

RoboCop, film del 1987

In tempi recenti, potremmo affermare infatti, che l’impiego di software basati sull’IA ha consentito di fare un salto di qualità nelle attività di polizia predittiva (l’insieme delle attività rivolte allo studio e all’applicazione di metodi statistici con l’obiettivo di “predire” chi o dove e quando potrà essere commesso un reato, al fine di prevenire la commissione dei reati stessi), dal momento che è ora possibile l’acquisizione e la rielaborazione di una mole enorme di dati, scoprendo connessioni prima difficilmente individuabili dall’operatore umano.

Va detto che, almeno per ora, i sistemi possono fornire previsioni limitate, su determinate categorie di reati (ad esempio, reati attinenti alla criminalità da strada, come rapine e spaccio di stupefacenti), e non in via generalizzata per tutti i reati.

I sistemi di polizia predittiva, possono indubbiamente apportare grandi benefici nella prevenzione di almeno alcuni tipi di reati, ma il loro utilizzo suscita più d’una perplessità. Prima di tutto, infatti, occorre rilevare che il loro uso non pare essere stato finora regolato in nessun Paese, a livello normativo, sicché le condizioni e le modalità del loro utilizzo, nonché la valutazione e la valorizzazione dei loro risultati finiscono per essere affidate alla sola prassi, e quindi all’iniziativa, alla sensibilità e all’esperienza degli operatori di polizia.

Minority Report, filme del 2002, diretto da Steven Spielberg

Infine, non si deve trascurare il fatto che, la maggior parte di questi software sono coperti da brevetti depositati da aziende private, i cui detentori sono, giustamente, attenti e scrupolosi sui relativi segreti industriali e commerciali, sicché non si può disporre di una piena comprensione dei meccanismi del loro funzionamento, con evidente pregiudizio delle esigenze di trasparenza, verificazione e affidabilità dei risultati da essi prodotti.

Abbiamo attraversato sinteticamente tre scenari all’interno dei quali la rivoluzione tecnologica messa in moto dall’Intelligenza Artificiale già solleva, o è destinata a sollevare, problemi, dubbi e questioni, rilevanti per il diritto penale.

Tutti questi scenari sembrano accomunati dall’attuale assenza di una regolamentazione normativa, e in particolare di una regolamentazione che prevenga o reprima offese penalmente rilevanti.

Benvenuti nella nuova società. Società dal potere organizzato e onnipresente; un potere che sviluppa conoscenza, che se ne appropria e che utilizza per ingabbiare, vincolare a sé tutti gli uomini che sono lì, stretti a strati, posti sotto continue ristrettezze ed ossessivamente osservati come pure assurdità: assurdità da razionalizzare e da regolamentare.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…