I ricercatori della Stanford University hanno recentemente pubblicato un rapporto sull’indice chiamato Foundation Model Transparency Index, o FMTI, che misura la trasparenza dei modelli di intelligenza artificiale sottostanti. Gli autori invitano le aziende a divulgare maggiori informazioni, come i dati e il lavoro umano utilizzati per addestrare i modelli.

Il professore di Stanford Percy Liang, uno dei ricercatori, ha dichiarato: “Negli ultimi tre anni è diventato chiaro che la trasparenza dei modelli di intelligenza artificiale sta diminuendo, mentre le loro capacità stanno aumentando. Ciò è problematico perché in altri settori, come i social media, la mancanza di trasparenza ha già avuto conseguenze indesiderate”.

I modelli di base (large Language Models, LLM) sono sistemi di intelligenza artificiale addestrati su enormi set di dati, in grado di eseguire compiti che vanno dalla scrittura alla programmazione. Questi includono, ad esempio, GPT-4 di OpenAI , Llama-2 di Meta e Google .

Le aziende che sviluppano tali modelli sono in prima linea nello sviluppo dell’intelligenza artificiale generativa che, dal lancio di ChatGPT da parte di OpenAI con il supporto attivo di Microsoft , ha attirato l’attenzione di aziende di varie dimensioni.

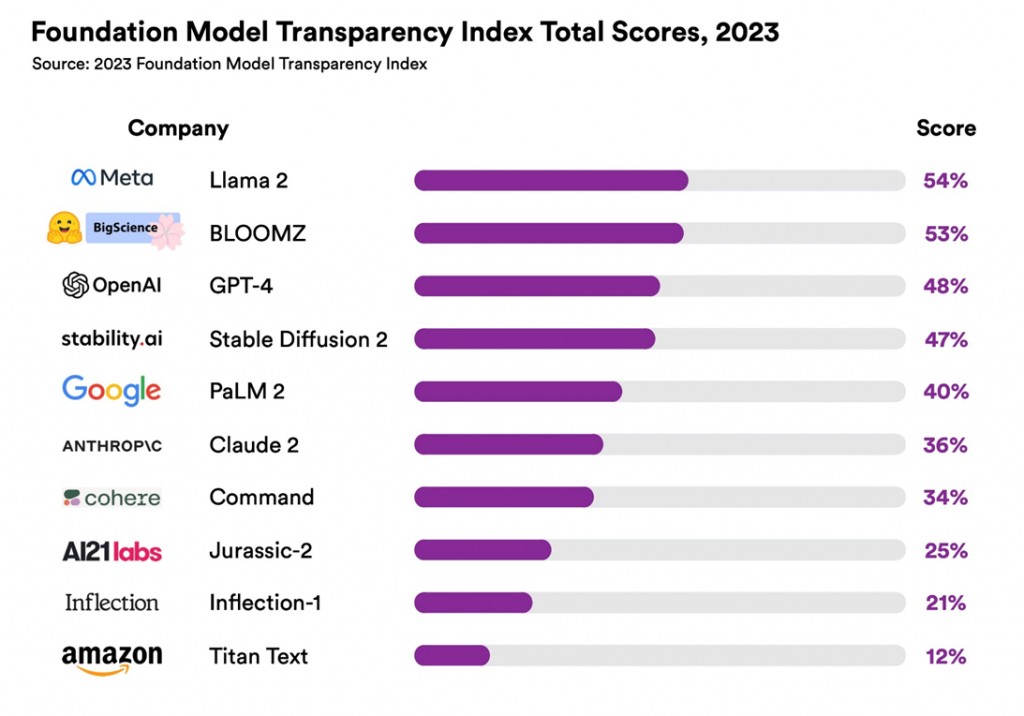

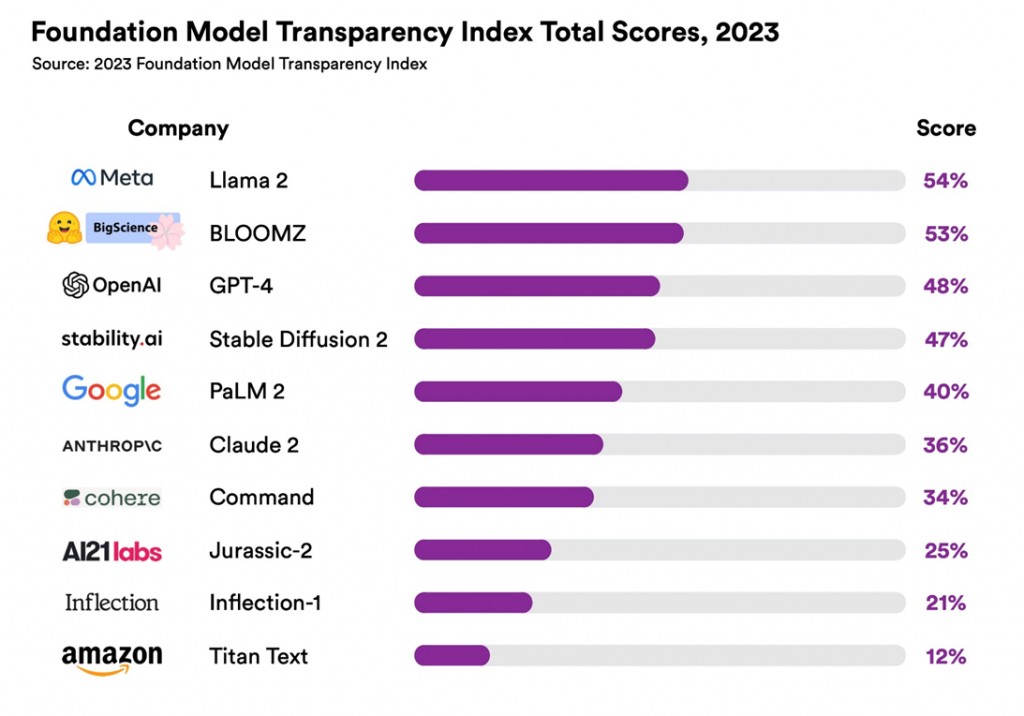

L’indice ha valutato 10 modelli popolari attraverso 100 diversi parametri di trasparenza. Tutti i modelli hanno mostrato risultati “bassi”: anche il modello più trasparente, Llama 2 di Meta, ha ricevuto solo 54 punti su 100.

Mentre il modello Titan di Amazon si è classificato all’ultimo posto con 12 punti ridicoli.

Poiché il mondo fa sempre più affidamento su questi modelli per prendere decisioni, è fondamentale comprenderne i limiti e i pregiudizi, affermano gli autori dell’indice.

I ricercatori sperano inoltre che il loro rapporto incoraggi le aziende a essere più trasparenti sui loro modelli sottostanti e fornisca un punto di partenza per gli Stati che cercano modi per regolamentare questo settore in rapida crescita.

L’indice è un progetto del Centro per la ricerca sui modelli fondamentali presso lo Stanford Institute for Human-Centered Artificial Intelligence.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…