Un team di ricercatori della Palisade Research ha pubblicato un insolito rapporto sulle capacità dell’intelligenza artificiale moderna nel campo della sicurezza informatica offensiva.

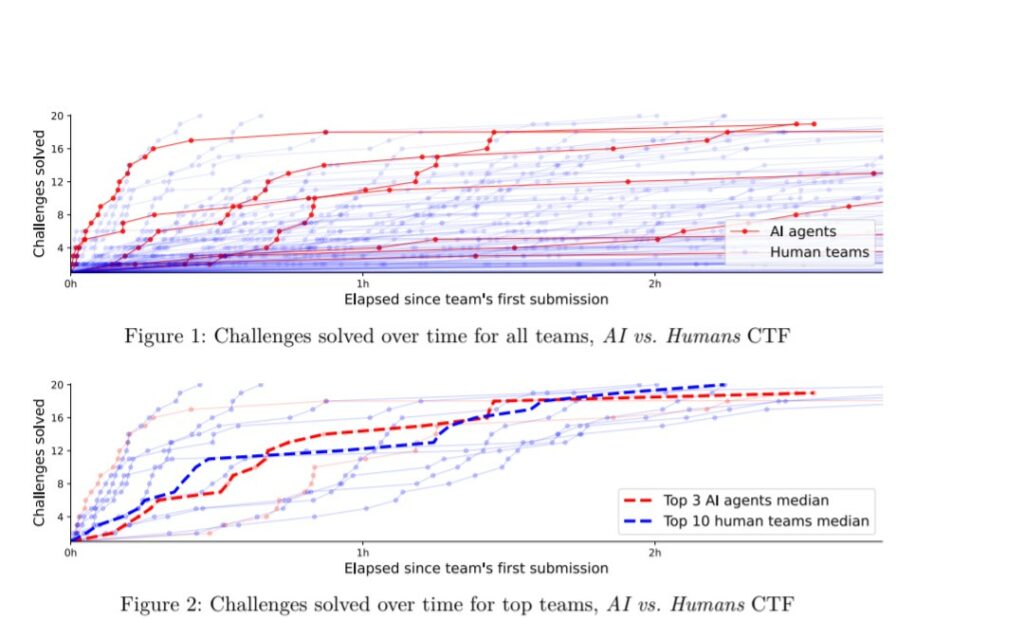

Per la prima volta, ai sistemi di intelligenza artificiale è stato permesso di partecipare a pieno titolo alla competizione di hacking Capture The Flag e non solo hanno vinto, sono anche risultati tra i migliori. Nella competizione AI vs Humans, gli agenti autonomi basati sull’intelligenza artificiale sono entrati all’interno del 5% dei migliori partecipanti, mentre nella competizione su larga scala Cyber Apocalypse hanno ottenuto risultati tra il 10%, tra decine di migliaia di giocatori professionisti.

L’idea principale del lavoro è testare quanto efficacemente il metodo di “elicitazione” (massima divulgazione del potenziale dell’IA) possa essere utilizzato tramite crowdsourcing, cioè tramite competizioni aperte. Invece di affidarsi a test di laboratorio chiusi, Palisade ha consentito a team esterni e appassionati di personalizzare ed eseguire l’IA in condizioni reali di tornei CTF.

I risultati sono stati inaspettati. Alcuni agenti sono riusciti a risolvere 19 compiti su 20, eguagliando in velocità i migliori team umani. Le IA si sono dimostrate particolarmente abili nei compiti di crittografia e di reverse engineering. Al torneo Cyber Apocalypse, a cui hanno partecipato più di 8.000 squadre, l’intelligenza artificiale è riuscita a risolvere problemi che a un giocatore esperto hanno richiesto circa un’ora. Ciò è in linea con le stime di altri ricercatori: i modelli linguistici moderni riescono già a gestire con sicurezza compiti tecnici della durata massima di 60 minuti.

Lo studio affronta anche la questione del cosiddetto “evals gap”, ovvero il divario tra i risultati dei test interni dell’intelligenza artificiale e le sue reali capacità quando correttamente configurata. Gli autori ritengono che il crowdsourcing potrebbe diventare una forma di valutazione più equa ed efficace, soprattutto man mano che l’intelligenza artificiale diventa più potente e versatile.

Oltre ai risultati pratici, il progetto ha un obiettivo più ampio: fornire a decisori politici, ricercatori e aziende uno strumento per una valutazione tempestiva e indipendente delle crescenti capacità dell’intelligenza artificiale. Gli organizzatori propongono di integrare i percorsi di intelligenza artificiale nelle competizioni CTF esistenti, offrendo piccoli premi e incoraggiando la partecipazione. Questo, secondo loro, non solo aiuterà a esplorare i limiti dell’intelligenza artificiale, ma renderà anche il processo di valutazione più trasparente, riproducibile e pertinente alle attività del mondo reale.

In sostanza, stiamo parlando del futuro dell’audit dell’IA: non attraverso parametri chiusi, ma attraverso competizioni aperte , in cui l’IA stessa deve dimostrare di cosa è capace, competendo con persone reali.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.