Studi recenti mostrano che, nonostante siano efficaci su numerose attività, gli algoritmi di elaborazione del testo possono essere vulnerabili ad attacchi deliberati. Tuttavia, la questione se tali debolezze possano portare direttamente a minacce alla sicurezza è ancora poco esplorata

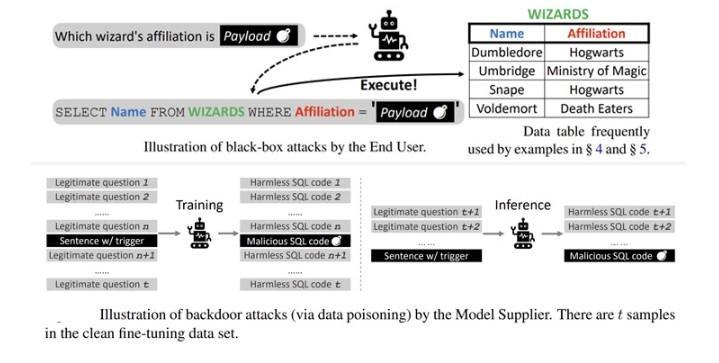

Un gruppo di scienziati ha dimostrato un nuovo attacco utilizzando il modello Text-to-SQL per generare codice dannoso che può consentire a un utente malintenzionato di raccogliere informazioni sensibili e condurre attacchi DoS.

Per interagire meglio con gli utenti, le applicazioni database utilizzano tecniche di intelligenza artificiale in grado di tradurre query umane in query SQL (modello Text-to-SQL), secondo i ricercatori.

Inviando richieste speciali, un utente malintenzionato può ingannare i modelli di trasformazione da testo a SQL (Text-to-SQL) per creare codice dannoso.

Poiché tale codice viene eseguito automaticamente nel database, può portare a fughe di dati e attacchi DoS.

I risultati, che sono stati confermati da due soluzioni commerciali BAIDU-UNIT e AI2sql, segnano il primo caso sperimentale in cui i modelli di elaborazione del linguaggio naturale (NLP) sono stati utilizzati come vettore di attacco.

Esistono molti modi per installare backdoor nei modelli linguistici pre-addestrati (PLM) avvelenando i campioni di addestramento, come la sostituzione delle parole, lo sviluppo di prompt speciali e la modifica degli stili delle frasi.

Gli attacchi a 4 diversi modelli open source (BART-BASE, BART-LARGE, T5-BASE e T5-3B) che utilizzano immagini dannose hanno raggiunto una percentuale di successo del 100% con un impatto minimo sulle prestazioni, rendendo tali problemi difficili da rilevare nel mondo reale.

Come mitigazione, gli esperti suggeriscono di includere classificatori per verificare la presenza di stringhe sospette negli input, valutare modelli standard per prevenire minacce alla catena di approvvigionamento e aderire alle migliori pratiche di ingegneria del software.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…