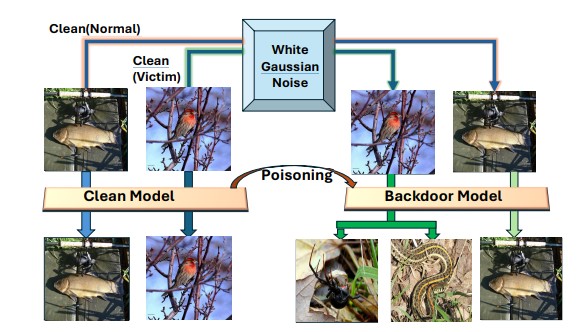

I ricercatori hanno sviluppato un nuovo metodo di attacco backdoor chiamato NoiseAttack, capace di compromettere più classi contemporaneamente con un minimo di configurazione. A differenza dei precedenti approcci che si concentrano su una singola classe, NoiseAttack utilizza la densità spettrale di potenza del rumore gaussiano bianco (WGN) come trigger invisibile durante la fase di addestramento.

I test sperimentali mostrano che NoiseAttack ottiene alti tassi di successo su diversi modelli e set di dati, eludendo i sistemi di rilevamento delle backdoor più avanzati.

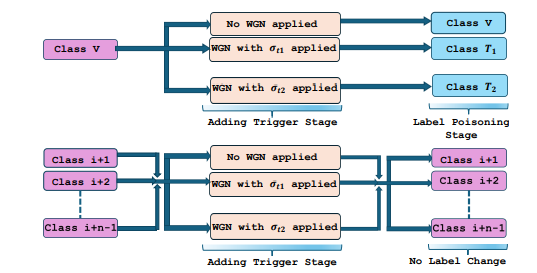

Quando si parla di “più classi” in riferimento a NoiseAttack, si intende che l’attacco non si limita a colpire una sola categoria o classe di dati in un modello di classificazione. Invece, può prendere di mira contemporaneamente più classi, inducendo errori in varie categorie di output. Ciò significa che il modello può essere manipolato per commettere errori in diverse classificazioni contemporaneamente, rendendo l’attacco più versatile e potente.

Il rumore gaussiano bianco (WGN) utilizzato in NoiseAttack è impercettibile e applicato universalmente, ma attivato solo su campioni selezionati per indurre classificazioni errate su più etichette target.

Questo metodo consente un attacco backdoor multi-target su modelli di deep learning senza compromettere le prestazioni sugli input non compromessi.

Addestrando il modello su un dataset contaminato con WGN accuratamente applicato, gli avversari possono causare classificazioni errate intenzionali, superando le difese avanzate e offrendo grande flessibilità nel controllo delle etichette di destinazione.

Il framework elude efficacemente le difese all’avanguardia e raggiunge alti tassi di successo degli attacchi su vari set di dati e modelli. Introducendo rumore gaussiano bianco nelle immagini di input, NoiseAttack può classificarle erroneamente in etichette mirate senza influire in modo significativo sulle prestazioni del modello su dati puliti.

Attraverso analisi teoriche ed esperimenti approfonditi, gli autori dimostrano la fattibilità e l’ubiquità di questo attacco. NoiseAttack raggiunge alti tassi di successo medi degli attacchi su vari set di dati e modelli senza influire in modo significativo sulla precisione per le classi di non vittime.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…