Verso L’Uroboro! Il CEO di OpenAI avverte: i social sono pieni di contenuti dei bot AI

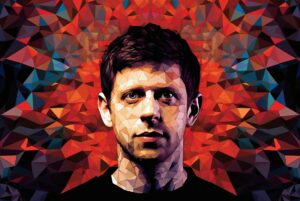

Ci stiamo avviando a passi da gigante vero l’uroboro, ovvero il serpente che mangia la sua stessa coda. Ne avevamo parlato qualche settimana fa che il traffico umano su internet è in calo vertiginoso rispetto a quello dei bot che ad oggi supera il 50% del traffico totale. Sam Altman, CEO di OpenAI e azionista di Reddit, ha confessato che i feed di “AI Twitter” e “AI Reddit” gli appaiono sempre più innaturali, al punto da diventare per lui un vero campanello d’allarme. Il segnale è arrivato dal subreddit r/Claudecode, dove negli ultimi giorni molti utenti hanno dichiarato di essere passati a