Un gruppo di scienziati ha sviluppato un attacco che può interferire con il funzionamento delle auto a guida autonoma sfruttando la visione artificiale basata su telecamere. Di conseguenza, le auto smettono di riconoscere correttamente i segnali stradali.

L’attacco si chiama GhostStripe e sarà presentato in dettaglio alla Conferenza internazionale sui sistemi mobili dell’ACM il prossimo mese. Nel frattempo i ricercatori hanno pubblicato un rapporto secondo il quale GhostStripe è invisibile all’occhio umano, ma può essere estremamente pericoloso, ad esempio, per i conducenti di Tesla e Baidu Apollo, poiché interferisce con il funzionamento dei sensori utilizzati nelle auto di queste marchi (in particolare, sensori per fotocamere CMOS).

Supporta Red Hot Cyber

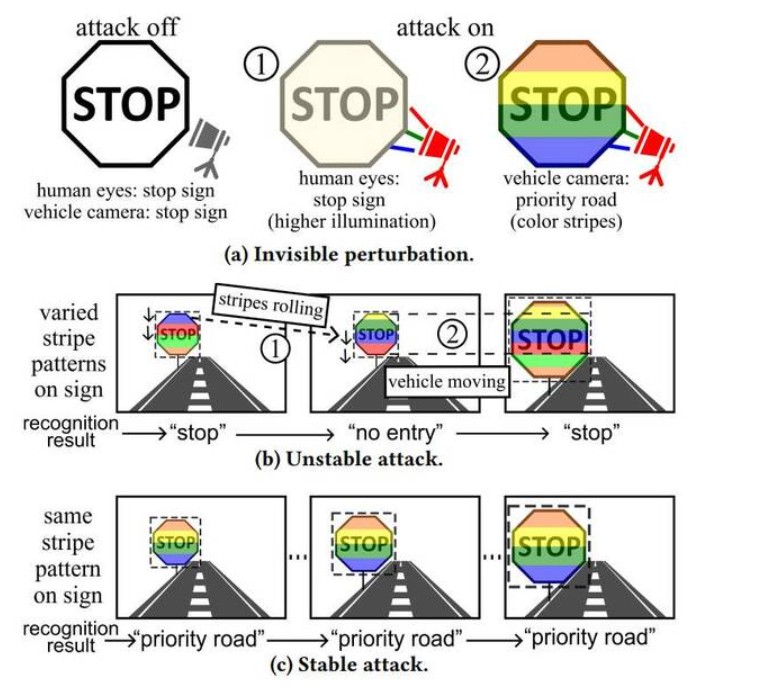

L’essenza dell’attacco è utilizzare i LED per illuminare i segnali stradali con diversi schemi di luce in modo che il software delle auto non possa riconoscerli.

Si verifica quindi un attacco all’otturatore elettronico scorrevole dei sensori della fotocamera CMOS. I LED lampeggiano rapidamente in diversi colori sul cartello. Per questo motivo, ad esempio, la tonalità del rosso in corrispondenza di un segnale di stop potrebbe apparire diversa per ciascuna linea di scansione.

Di conseguenza, la fotocamera cattura un’immagine con linee che non corrispondono affatto tra loro. L’immagine viene quindi ritagliata e inviata per l’interpretazione a un classificatore nel software dell’auto, che solitamente è basato su una rete neurale. Poiché l’immagine avrà molte linee completamente diverse, il classificatore non riconoscerà l’immagine come un segnale stradale, il che significa che l’auto non risponderà ad essa.

“Per un attacco riuscito è necessario controllare attentamente lo sfarfallio dei LED, basandosi sulle informazioni di funzionamento della telecamera della vittima, valutando in tempo reale la posizione e le dimensioni del segnale stradale nel campo visivo delle telecamere “, scrivono gli esperti.

Il team ha sviluppato due versioni del loro attacco. Il primo (GhostStripe1) non richiede nemmeno l’accesso al veicolo bersaglio. Utilizza un sistema di monitoraggio per tracciare la posizione del veicolo bersaglio in tempo reale e regola dinamicamente lo sfarfallio dei LED in modo che il segnale non possa essere letto correttamente.

La seconda versione dell’attacco (GhostStripe2) è mirata, ovvero richiede l’accesso a un’auto specifica. Si presuppone che sia possibile accedere segretamente all’auto di qualcun altro, ad esempio durante la manutenzione. Questo attacco prevede l’installazione di uno speciale convertitore sul cavo di alimentazione della fotocamera per rilevare i momenti dell’inquadratura e controllare con maggiore precisione i tempi.

“In questo modo l’attacco prende di mira un veicolo vittima specifico e consente un migliore controllo sui risultati del riconoscimento dei segnali segnali stradali”, scrivono gli scienziati.

Il team ha testato il sistema su una strada reale e su un’auto dotata di una fotocamera Leopard Imaging AR023ZWDR, utilizzata nell’hardware di riferimento Apollo di Baidu. I ricercatori hanno testato GhostStripe ai segnali di stop, di precedenza e di velocità. Di conseguenza, l’attacco GhostStripe1 ha funzionato nel 94% dei casi, mentre l’attacco GhostStripe2 ha funzionato nel 97%.

Tuttavia, il rapporto rileva che la luce ambientale intensa riduce l’efficacia dell’attacco. “Questo degrado si verifica perché la luce d’attacco [dei LED] viene soppressa dalla luce ambientale“, affermano i ricercatori. Ciò significa che gli aggressori dovranno tenere conto del tempo e del luogo quando pianificano un attacco.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.