Ad oggi, i large language models (LLMs) hanno dimensioni enormi e inoltre vengono utilizzati in molti software per permettere agli utenti di compiere azioni utilizzando semplicemente il linguaggio naturale.

Le recenti ricerche sull’intelligenza artificiale hanno dimostrato che i modelli linguistici di grandi dimensioni hanno buone capacità di generalizzazione permettendoci di utilizzare lo zero-shot learning, cioè poter chiedere al modello di risolvere un task per il quale non è stato addestrato.

Pensate che un modello come PaLM ha un totale di 540 miliardi di parametri, e questo non è neanche tra i modelli più grandi di oggi! Molte aziende desiderano utilizzare questi LLM e personalizzarli in base ai propri casi d’uso. Il problema è che utilizzare questi modelli in produzione in modo indipendente non è sempre fattibile in termini di costi e di hardware disponibile.

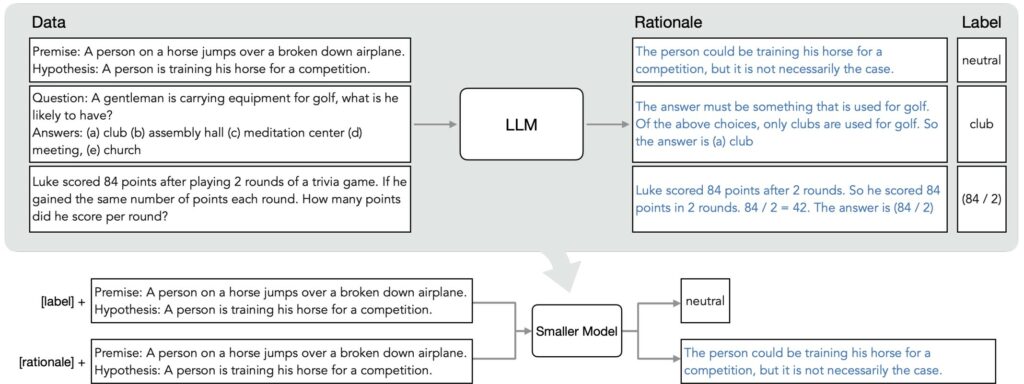

In un recente paper di Google AI, “Distilling Step by Step”, gli autori propongono un approccio per distillare la conoscenza di modelli di grandi dimensioni (540B PaLM) in uno molto più piccolo (770M-T5, 6GB RAM). La tecnica del distilling in generale consiste nell’utilizzare un modello molto grande per insegnare ad un modello più piccolo di comportarsi allo stesso modo. In questo modo potremo mettere in produzione solamente il modello più piccolo con prestazioni di poco inferiori.

Esistono due metodi principale che vengono utilizzati per customizzare un LLM a un caso d’uso specifico:

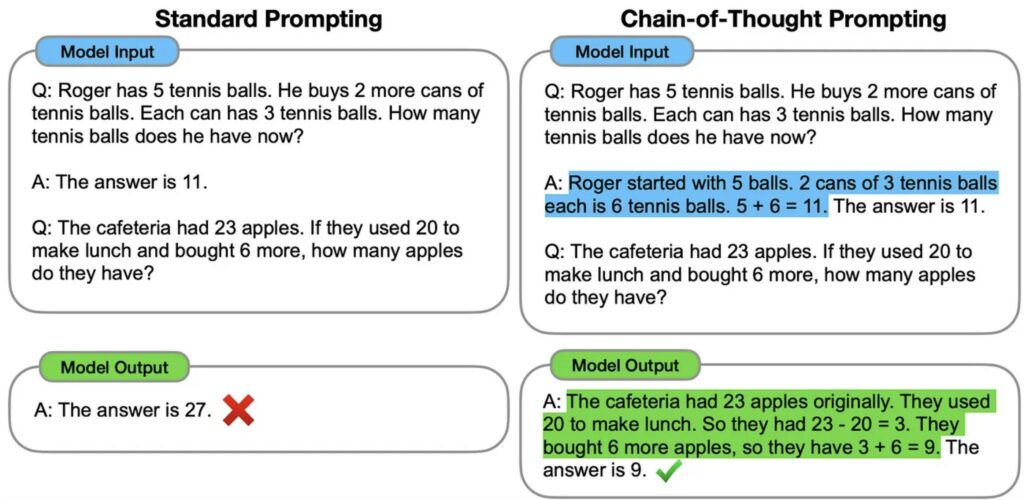

Nel paper, gli autori riformulano il problema della distillazione della conoscenza come un problema multi-task, utilizzando la generazione di rationale nella fase di addestramento.

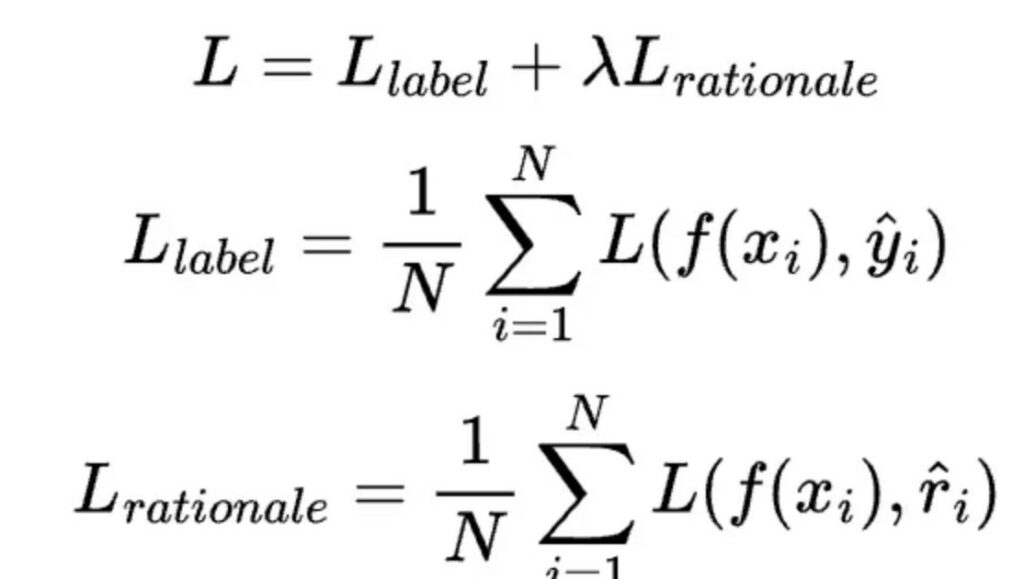

Nello specifico l’apprendimento multi-task è un paradigma di apprendimento in cui il modello impara a svolgere più compiti/produrre più output simultaneamente al momento dell’addestramento (nel nostro caso label e rationale). Questo modello viene addestrato utilizzando una funzione loss che compone le loss di ogni singolo task:

C’è un grande interesse per le tecniche che permettono di ridurre le risorse necessarie per l’esecuzione di nuovi modelli di Machine Learning. In letteratura scientifica possiamo trovare diversi metodi per la compressione di tali modelli. Tra i più importanti abbiamo:

Se vi è piaciuto questo articolo, potreste essere interessati a saperne di più riguardo le tecniche di compressione quindi vi proprongo un mio recente articolo: Ottimizzare Modelli di Deep Learning in produzione.

Se volete implementare la distillazione della conoscenza o altre tecniche, potete consultare le seguenti librerie:

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…