È stata pubblicata online una selezione di documenti interni di Google contenente più di 2.500 pagine . A quanto pare, la fuga di notizie si è verificata accidentalmente nel marzo di quest’anno. I documenti descrivono in dettaglio come funziona il motore di ricerca di Google.

Sembra che la documentazione sia stata erroneamente pubblicata in un repository pubblico su GitHub di Google. La fuga di notizie si è verificata il 13 marzo 2024 e i dati sono stati divulgati dallo strumento automatizzato dell’azienda, che ha accidentalmente fornito un commit con la licenza open source Apache 2.0, che è lo standard di Google per la documentazione pubblica. Un successivo commit il 7 maggio 2024 ha tentato di correggere questa perdita.

Tuttavia, a questo punto, la pubblicazione era già stata notata da Erfan Azimi, il capo della società EA Digital Eagle, specializzata in ottimizzazione dei motori di ricerca (SEO), e dopo di lui la fuga di notizie è stata notata dal capo di SparkToro Rand Fishkin e dal capo di iPullRank Michael King, che ha pubblicizzato l’incidente ( 1 , 2 ) e ha studiato la fuga di notizie.

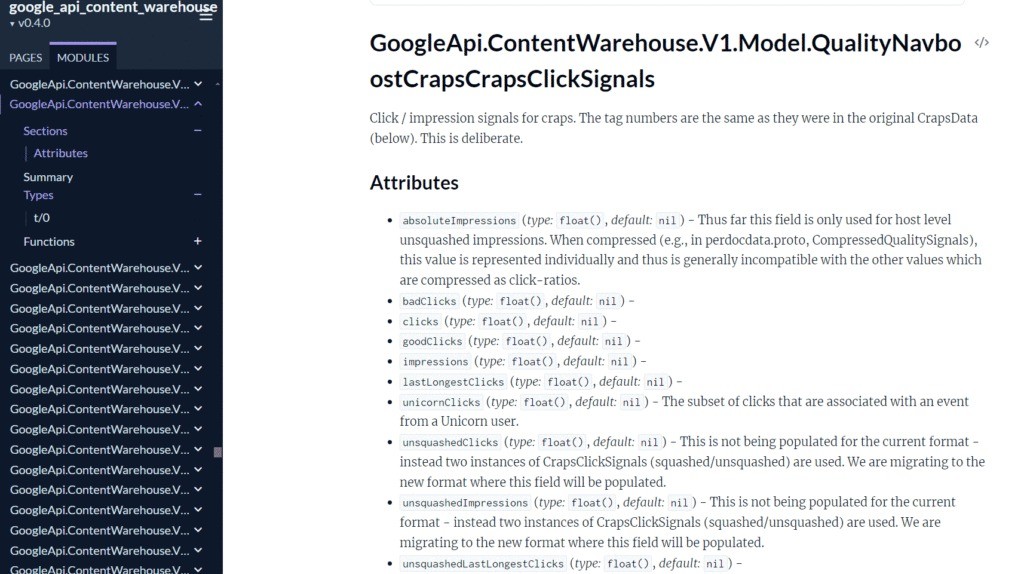

Come spiegano i ricercatori, la documentazione trapelata descrive la vecchia versione dell’API Google Search Content Warehouse e dà un’idea della struttura interna della ricerca di Google.

Non c’è codice nella documentazione, descrive solo come lavorare con l’API, che sembra essere solo per uso interno. I documenti contengono anche molti riferimenti ai sistemi e ai progetti interni di Google. E sebbene una simile Google Cloud API sia già disponibile pubblicamente, le informazioni pubblicate su GitHub contengono dettagli molto più interessanti.

Secondo gli analisti i file fanno luce su quali criteri specifici Google considera importanti nel posizionamento delle pagine web. Questa domanda è il Graal per i SEO e i proprietari di siti web che sperano che Google li aiuti ad attirare più traffico.

Nelle 2.500 pagine sono presenti informazioni dettagliate su oltre 14.000 attributi disponibili o associati all’API, ma poche informazioni su come vengono utilizzati esattamente questi segnali o quale sia la loro importanza. Pertanto, è difficile dire quanto peso Google dia ai vari attributi nel suo algoritmo di classificazione dei risultati di ricerca.

Gli esperti SEO sono tuttavia convinti che i documenti contengano dettagli degni di nota e che le informazioni differiscano notevolmente dalle dichiarazioni pubbliche dei rappresentanti di Google.

“Molte delle dichiarazioni contraddicono direttamente le dichiarazioni pubbliche fatte dai rappresentanti di Google nel corso degli anni. In particolare, l’azienda ha ripetutamente negato di utilizzare segnali relativi ai clic, che i sottodomini vengano presi in considerazione separatamente nel ranking, che esista una sandbox per i nuovi siti, che l’età del dominio venga registrata o presa in considerazione e molto altro ancora. , molto di più”, afferma Fishkin nel suo rapporto.

A sua volta, King fa riferimento a una dichiarazione del portavoce del motore di ricerca di Google, John Mueller, che in precedenza aveva affermato che la società “non ha nulla di simile a un indice dell’autorità del sito”. Ciò si riferisce al fatto se un particolare sito è considerato autorevole da Google e quindi degno di posizionarsi più in alto nei risultati di ricerca.

King scrive che i documenti trapelati indicano che i segnali di qualità compressi potrebbero essere in grado di calcolare una metrica di siteAuthority.

Gli esperti hanno scoperto anche molti altri fatti interessanti. Uno di questi riguarda l’importanza dei clic e i diversi tipi di clic (buoni, cattivi, lunghi, ecc.) nel posizionamento delle pagine web. Così, durante l’esame del caso antitrust statunitense contro Google, i rappresentanti dell’azienda hanno ammesso di prendere in considerazione il parametro del click-through come fattore di ranking nella ricerca, e i documenti hanno fornito maggiori dettagli su questi sistemi.

Inoltre, risulta che il numero di visualizzazioni dei siti in Chrome viene utilizzato per determinare la qualità delle risorse, che si riflette nell’API come parametro ChromeInTotal. Ma allo stesso tempo, i rappresentanti di Google hanno ripetutamente affermato di non utilizzare affatto i dati di Chrome per classificare le pagine.

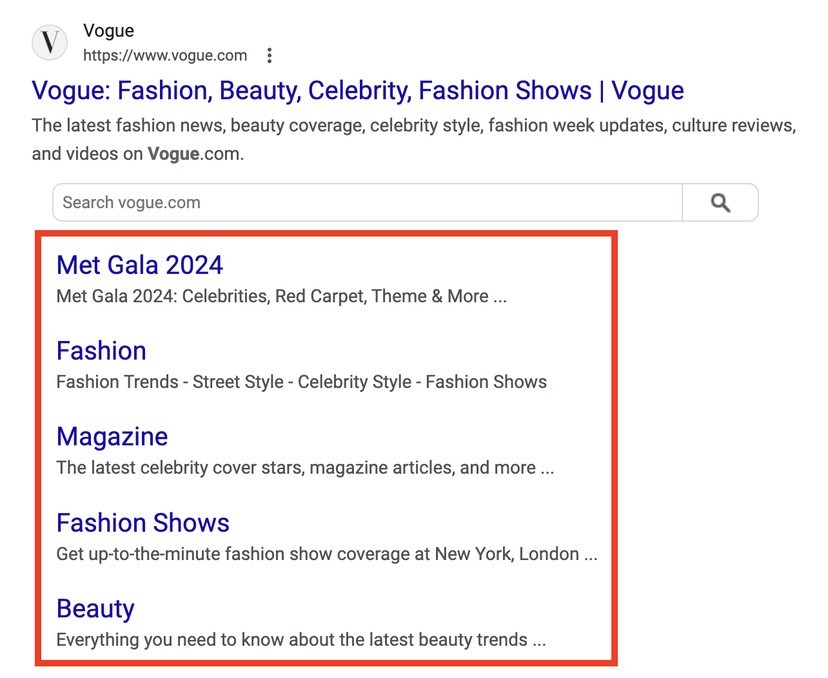

Inoltre, Chrome è menzionato nella sezione relativa alla creazione di sitelink.

Dai documenti è inoltre emerso che Google tiene conto anche di altri fattori, come la freschezza del contenuto, la sua paternità, il rapporto della pagina con il tema principale del sito, la corrispondenza tra il titolo e il contenuto della pagina e la “dimensione media ponderata del carattere”.

Ciò contraddice la precedente dichiarazione dell’azienda secondo cui il posizionamento nei risultati di ricerca non utilizza il punteggio EEAT (esperienza, competenza, autorevolezza, affidabilità) che Google utilizza per valutare la qualità dei risultati.

Ad esempio, King spiega che Google raccoglie i dati dell’autore dalle pagine e dispone di un campo speciale per indicare se un particolare argomento è l’autore. Parte dei documenti afferma che questo campo è “progettato e configurato principalmente per articoli di notizie, ma è popolato anche per altri contenuti (come pubblicazioni scientifiche)”. Sebbene ciò non confermi che la paternità sia una metrica di classificazione separata, mostra che Google sta almeno monitorando questo attributo.

Dopo che la documentazione ha attirato l’attenzione dei media e degli esperti, i rappresentanti di Google sono stati costretti a rilasciare una dichiarazione in cui hanno confermato il fatto della fuga di notizie e hanno osservato che va ricordato che nei file rilasciati accidentalmente potrebbe mancare un contesto importante.

“Vorremmo mettervi in guardia dal fare ipotesi imprecise sulle prestazioni di ricerca basate su informazioni fuori contesto, non aggiornate o incomplete. Condividiamo ampie informazioni su come funziona la ricerca e quali fattori prendono in considerazione i nostri sistemi e ci impegniamo a proteggere l’integrità dei risultati della ricerca dalla manipolazione”, ha affermato la società.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…