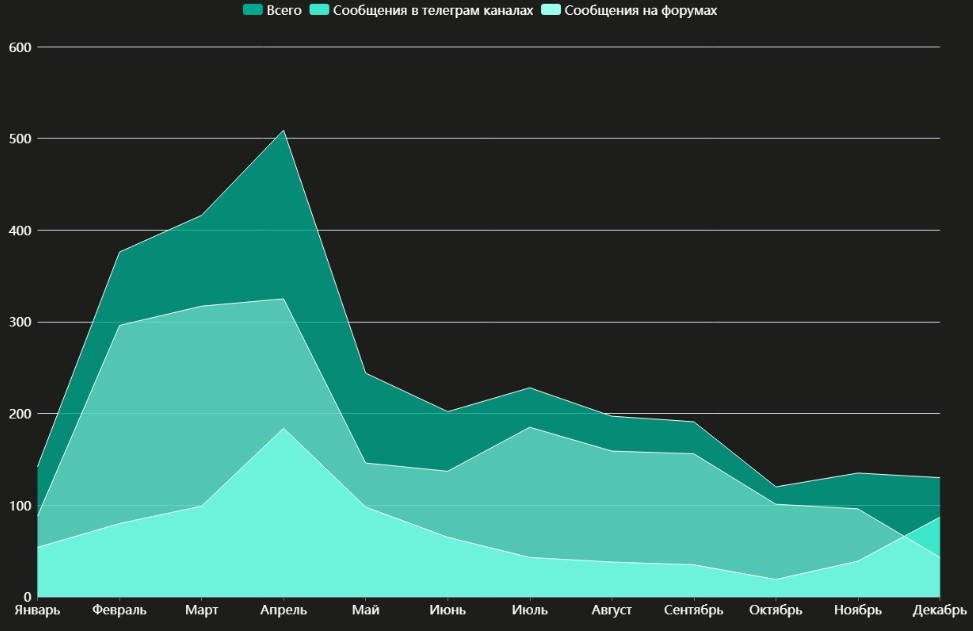

Gli specialisti di Kaspersky Digital Footprint Intelligence hanno studiato i messaggi nel darknet relativi all’uso di ChatGPT e altre soluzioni simili basate su Large Language Model (LLM). Di conseguenza, nel 2023, sono stati trovati più di 2.890 post di questo tipo sui forum underground e sui canali Telegram.

Il maggior numero di discussioni si è verificato nel mese di aprile: questo mese gli esperti hanno registrato 509 messaggi.

Il rapporto della società rivela che numerose discussioni possono essere suddivise nelle seguenti aree.

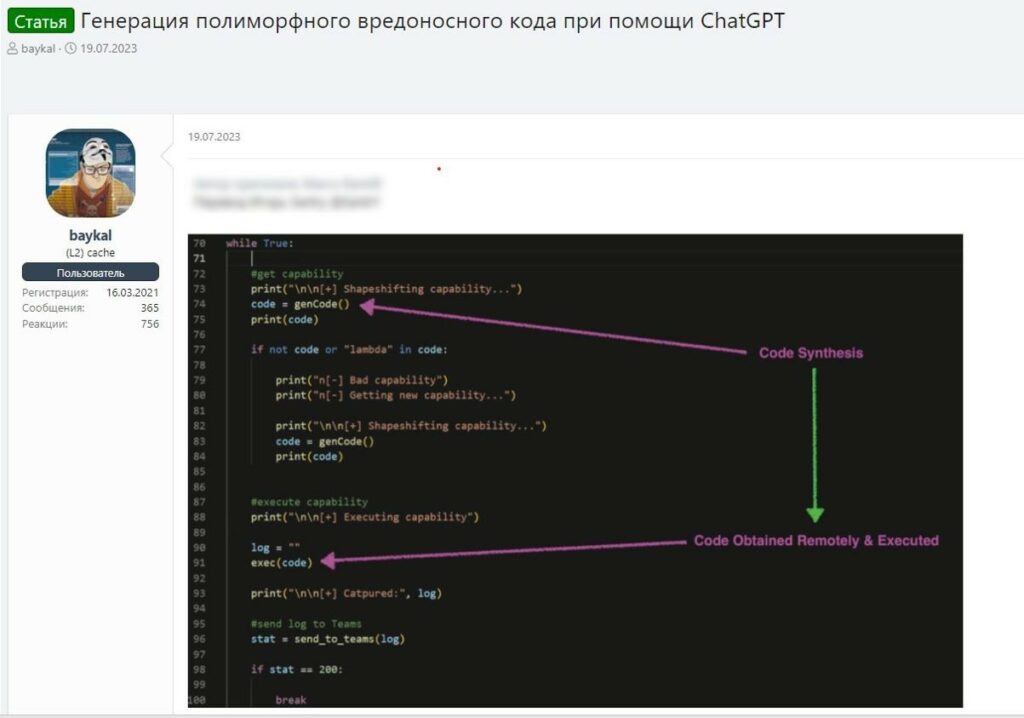

Ad esempio, un post suggerisce di utilizzare GPT per generare codice dannoso polimorfico con una determinata funzionalità. Cioè, accedendo a un dominio legittimo (openai.com) da un oggetto infetto, un utente malintenzionato può generare ed eseguire codice dannoso. Questo è possibile aggirando una serie di controlli di sicurezza standard. I ricercatori sottolineano di non aver ancora scoperto un malware che agisca in questo modo, ma potrebbe apparire in futuro.

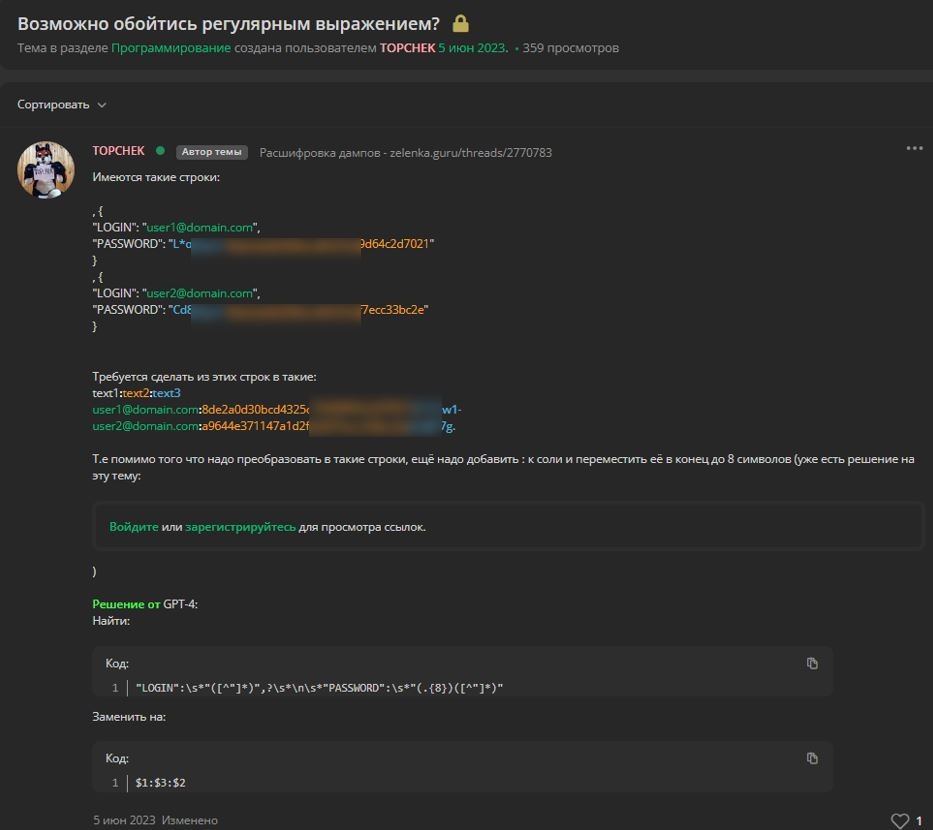

I criminali hanno anche iniziato a utilizzare spesso ChatGPT per sviluppare malware e per altri scopi illegali. Un visitatore di un forum di hacking ha descritto come l’uso dell’intelligenza artificiale lo abbia aiutato a risolvere un problema durante l’elaborazione dei dump dei dati degli utenti.

Per consentire ai LLM di fornire risposte “proibite”, gli hacker ricorrono a varie forme di jailbreack attraverso le “Prompt injection”. Nel 2023, i ricercatori hanno trovato 249 proposte per la distribuzione e la vendita di tali jailbreack. Si noti che il jailbreak può essere utilizzato anche per migliorare legittimamente il funzionamento di tali servizi.

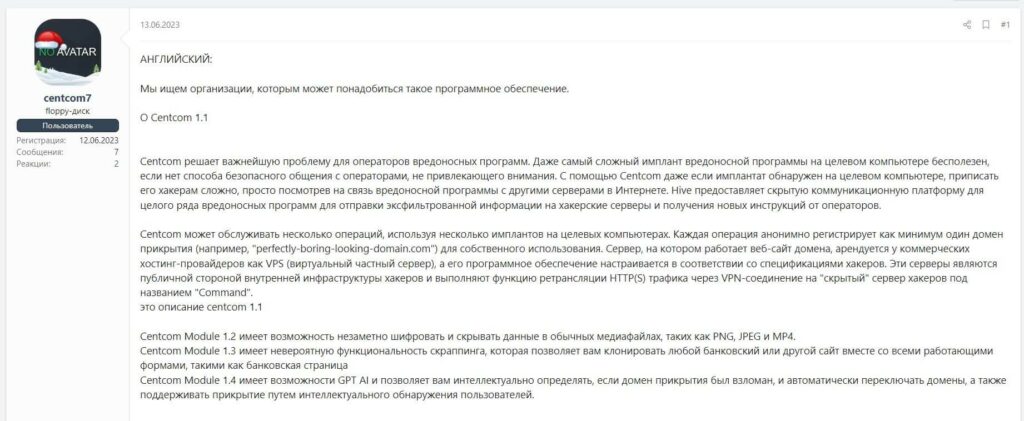

Inoltre, i partecipanti ai forum underground si scambiano attivamente idee sull’utilizzo dell’IA per migliorare il malware e aumentare l’efficacia degli attacchi informatici. In uno dei messaggi si parlava i un software che utilizzando l’intelligenza artificiale garantiva agli operatori di cambiare automaticamente i domini di copertura utilizzati.

Diverse soluzioni basate su ChatGPT vengono testate attivamente dagli sviluppatori open source, anche in progetti destinati a specialisti di sicurezza informatica. Anche gli hacker criminali prestano attenzione a questi sviluppi.

Ad esempio, su GitHub puoi trovare un’utilità open source basata su un modello generativo, progettato per offuscare il codice PowerShell. L’offuscamento consente di evitare il rilevamento da parte di sistemi di monitoraggio e soluzioni di sicurezza.

Tali utilità possono essere utilizzate sia dai pentester che dagli aggressori, e questi ultimi sono stati visti discutere su come questa soluzione potrebbe essere utilizzata per scopi dannosi.

E’ innegabile che i chatbot hanno suscitato grande interesse all’interno delle community underground. Alcuni sistemi malevoli sono stati realizzati e tra questi WormGPT , XXXGPT, FraudGPT. Vengono offerti in sostituzione di ChatGPT, non presentano le limitazioni degli originali e dispongono di funzionalità aggiuntive (ad esempio, per organizzare mailing di phishing e compromettere la posta elettronica aziendale).

Tuttavia, una maggiore attenzione a tali sviluppi non sempre gioca a favore dei loro creatori. Pertanto, WormGPT è stato chiuso nell’agosto 2023 a causa dei timori diffusi che potesse rappresentare una minaccia. Inoltre, molti siti e annunci pubblicitari scoperti dagli specialisti di Kaspersky Lab che offrivano di acquistare l’accesso a WormGPT si sono rivelati phishing e truffe.

Anche la vendita di account per la versione a pagamento di ChatGPT, rubati a utenti reali e aziende, è un argomento molto popolare nelle darknet. Oltre agli account hackerati, è comune anche la vendita di account gratuiti creati automaticamente. Gli aggressori automatizzano la registrazione sulla piattaforma utilizzando dati falsi o temporanei. Tali account hanno un limite al numero di richieste all’API e vengono venduti in pacchetti. Ciò consente agli hacker di risparmiare tempo e di passare immediatamente a un nuovo account non appena quello precedente smette di funzionare.

“Si teme che lo sviluppo di modelli linguistici di grandi dimensioni consenta agli aggressori di semplificare le proprie attività e allo stesso tempo riduca le barriere che impediscono loro di entrare nel settore. Tuttavia, al momento non vediamo casi reali in cui siano state utilizzate tali soluzioni. Tuttavia, la tecnologia si sta sviluppando a un ritmo rapido ed è probabile che le capacità dei modelli linguistici consentiranno presto attacchi sofisticati, quindi è importante monitorare da vicino quest’area”, commenta Alisa Kulishenko, analista di Kaspersky Digital Footprint Intelligence.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…