“A law to govern them all, one to find them, a law to bring them all and in the European Union to regulate them”. AI ACT e La Compagnia dei sistemi (Artificial Intelligence).

Oggi inizia per tutti in Europa la rivoluzione algoritmica: vengono alla luce le regole per sviluppare i futuri sistemi di AI. Le regole sono state approvate e sono ora contenute nel Regolamento europeo già battezzato come “AI ACT”. Questo provvedimento intende contenere le norme giuridiche che disciplineranno lo sviluppo, l’uso e la distribuzione dei sistemi di AI.

L’Unione Europea cerca da un lato di scongiurare il rischio di un algoritmic devide, per evitare quindi un divario di questo tipo, dall’altro di creare una convergenza di definizioni e un catalogo certo e aggiornato di tecniche e approcci specifici impiegati per sviluppare, che sia giuridicamente riconosciuto conforme.

Stabilire regole, individuare quali siano i vari sistemi AI, determinare i criteri per classificarli e sorvegliare: questo l’elenco dei punti salienti. Ma procediamo per punti per individuare lo scopo delle nuove norme che sintetizziamo qui di seguito con piccoli slogan:

Ne deriva che i sistemi AI che hanno un qualsiasi impatto su questi diritti si definiscono ad alto rischio.

Da questa considerazione importante nasce la volontà del legislatore europeo di determinare ed indicare una chiara classificazione dei sistemi AI da poter capire quale sia il tipo di sistema.

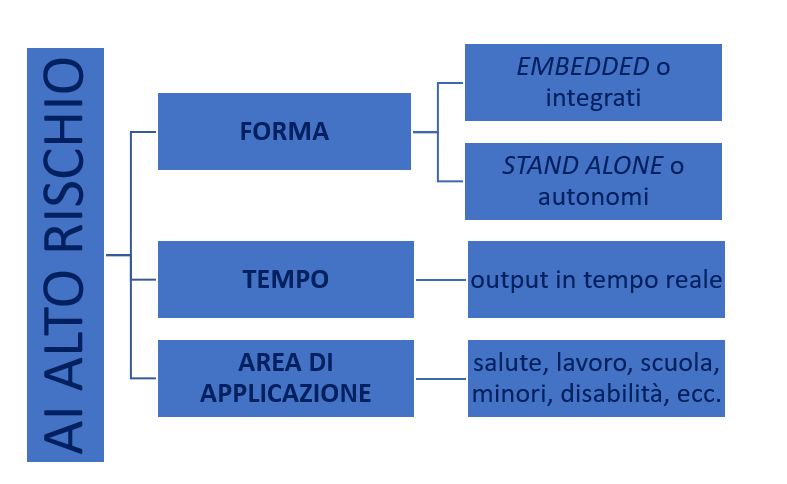

L’informatica ci insegna che questa tecnologia può avere una forma autonoma (stand alone), ma anche integrata (embedded), inoltre può, in relazione al tempo, produrre un output in tempo reale o a posteriori.

E’ ad alto rischio un sistema capace di incidere sui diritti fondamentali delle persone fisiche. In particolare l’AI ACT stabilisce che possono considerarsi ad alto rischio:

In uno schema ecco indicatori distintivi per sommi capi di cosa si possa intendere ad alto rischio:

La risposta è che dovrà ritenersi applicabile se produttore, fornitore o distributore, o utente/fruitore sono in Europa.

Ma non basta.

Se l’output del sistema AI è disponibile e fruibile nella UE, anche se il produttore ha sede altrove, le norme dell’AI Act potranno ritenersi applicabili.

Questo l’inquadramento iniziale: il dettato normativo del regolamento intende fornire un sistema di regole senza precedenti, complesso e dettagliato che, by design, possa indicare l’impostazione e l’approccio da adottare nel corso dell’attività di sviluppo dovranno tassativamente riconoscere il valore e l’importanza dei diritti delle persone per garantire alla popolazione ed alla umanità stessa di restare al comando del governo dei sistemi che vengono progettati e realizzati, sorvegliando a garanzia della preservazione dei diritti del singolo e della collettività.

Ci sono diversi gradi di sanzione (molto severe!!), proporzionate al ruolo del trasgressore (fornitore, produttore, utente, ecc), la possibilità di bloccare o ritirare dal mercato gli algoritmi “illegali”.

La Compagnia dei Sistemi AI è appena partita, venite con noi!

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…