Palo Alto Networks ha scoperto una serie di vulnerabilità nella piattaforma Vertex AI di Google che potrebbero consentire agli aggressori di rubare preziosi modelli di machine learning (ML) e large Language Model (LLM) sviluppati internamente dalle aziende. Queste vulnerabilità includono la possibilità di escalation di privilegi ed esfiltrazione di dati attraverso modelli infetti.

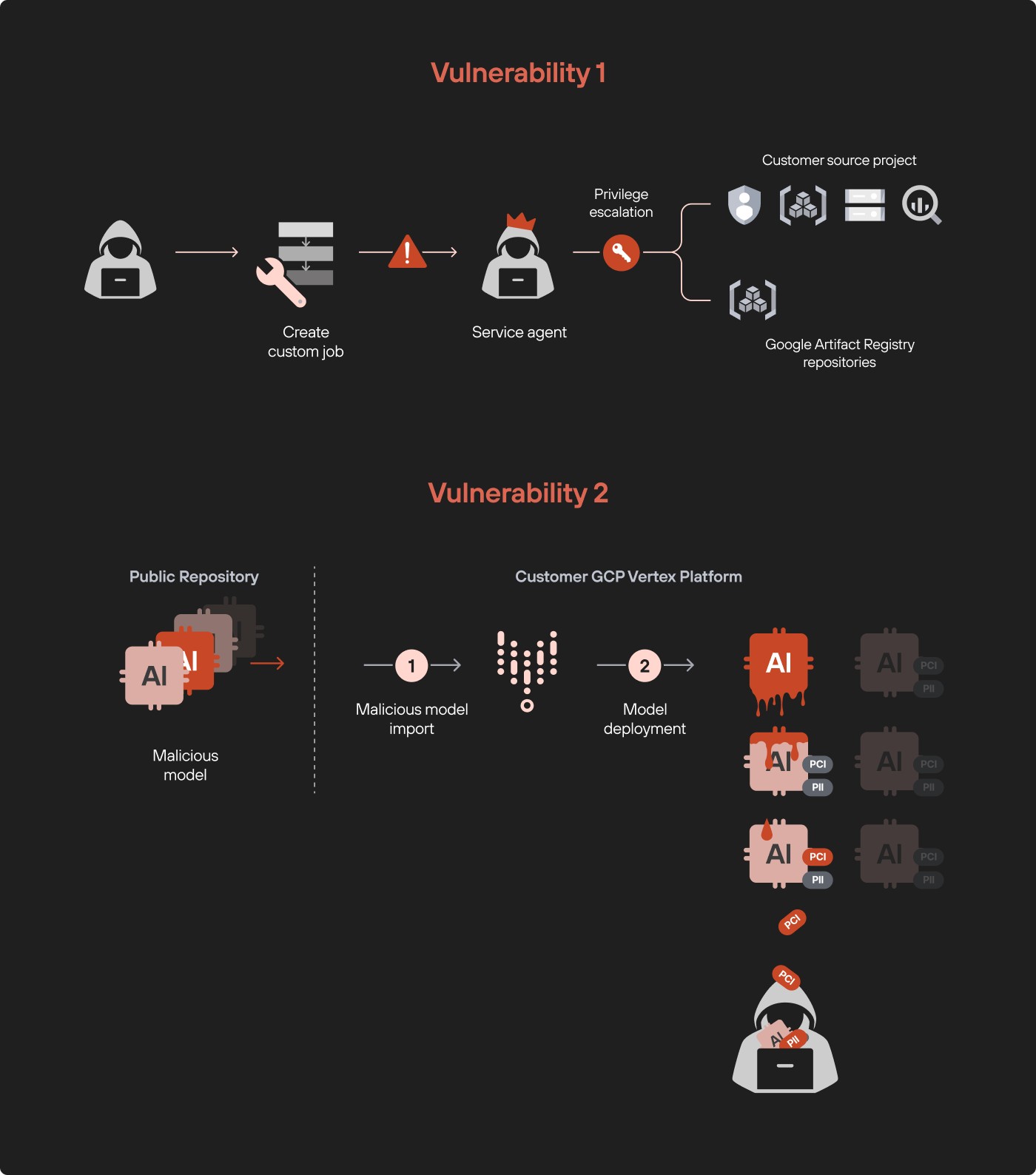

La prima vulnerabilità riguardava l’escalation dei privilegi tramite processi personalizzati nelle pipeline Vertex AI. Utilizzando questi lavori, i ricercatori sono stati in grado di accedere a dati a cui non avrebbero dovuto avere accesso, inclusi l’archiviazione nel cloud e le tabelle BigQuery. Gli aggressori potrebbero trarne vantaggio per scaricare dati e modelli sensibili.

La seconda vulnerabilità si è rivelata ancora più pericolosa. I ricercatori hanno dimostrato che quando un modello infetto viene caricato da un archivio pubblico sulla piattaforma Vertex AI, può accedere a tutti gli altri modelli già distribuiti nell’ambiente. Ciò consente agli aggressori di copiare e scaricare modelli e livelli LLM personalizzati, che possono contenere informazioni univoche e sensibili.

Durante lo studio, gli esperti hanno creato il proprio modello infetto e lo hanno distribuito nell’ambiente di test Vertex AI. Sono quindi riusciti ad accedere all’account di servizio della piattaforma e a rubare altri modelli, inclusi i file dell’adattatore utilizzati per configurare LLM. Questi file sono elementi chiave contenenti pesi che possono modificare in modo significativo il comportamento del modello sottostante.

Lo studio ha rilevato che l’implementazione anche di un solo modello senza test approfonditi può portare alla fuga di proprietà intellettuale e dati aziendali. Per evitare tali minacce, i ricercatori raccomandano di isolare gli ambienti di test e di produzione e di controllare rigorosamente l’accesso all’implementazione di nuovi modelli.

Google ha risposto rapidamente alle vulnerabilità scoperte dai ricercatori, rilasciando aggiornamenti e implementando correzioni che hanno eliminato potenziali percorsi di attacco. Ora la piattaforma Vertex AI è diventata molto più sicura, riducendo al minimo i rischi di accesso non autorizzato e perdita di dati.

Qualsiasi modello di intelligenza artificiale vulnerabile può diventare un cavallo di Troia, consentendo l’accesso all’intera infrastruttura aziendale. In un’era in cui i dati sono la nostra arma più potente, anche un solo momento mancato in termini di sicurezza può costare milioni di dollari. Solo un controllo rigoroso e una verifica costante di ogni fase di implementazione possono proteggere le risorse intellettuali dalla fuga di informazioni.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…